samedi, 20 mars 2021

Des robots de Rossum à l'intelligence artificielle

Des robots de Rossum à l'intelligence artificielle

par Leonid SAVIN

Le 25 janvier 2021 marque le centenaire de la première de la pièce de théâtre R.U.R. (Rossum's Universal Robots) de l'écrivain tchèque de science-fiction Karel Čapek. Cette courte œuvre a anticipé les livres ultérieurs sur le sujet, ainsi que les films cyberpunk et post-apocalyptiques comme Terminator et Alien: Covenant. Les robots universels de Rossum ont été conçus comme des assistants des humains, mais après un certain temps, ils se rebellent et détruisent la race humaine, à l'exception d'un ouvrier d'usine, dont ils ont besoin pour recréer leur propre espèce.

Karel Capek.

Le mot "robot" s'est rapidement banalisé et a été appliqué à des mécanismes dotés d'un ensemble limité de fonctions programmables et nécessitant un diagnostic, un entretien et une réparation. Plus récemment, cependant, notamment après le développement des ordinateurs et des cyber-technologies, des discussions sont déjà en cours pour savoir si les machines peuvent penser et prendre des décisions sur un pied d'égalité avec les personnes.

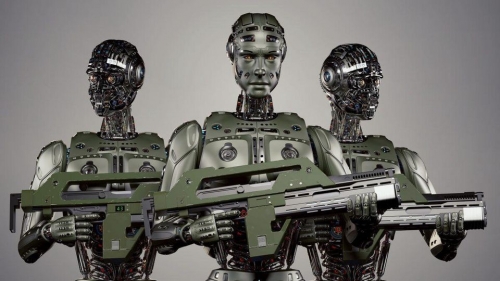

Les dernières réalisations en matière de robotique et d'informatisation ne sont nulle part plus demandées que dans l'armée, notamment aux États-Unis, où des centres spéciaux ont été créés pour développer des programmes, des applications et du matériel spécifiques. De nombreux laboratoires de l'armée américaine, du corps des Marines, de la marine et de l'armée de l'air, avec l'aide de contractants et des principales institutions du pays, mènent à bien les prototypes de modèles avancés - toute cette technologie doit servir les nouvelles guerres que Washington prévoit de déclencher à l'avenir.

Les récentes avancées dans ce domaine sont révélatrices.

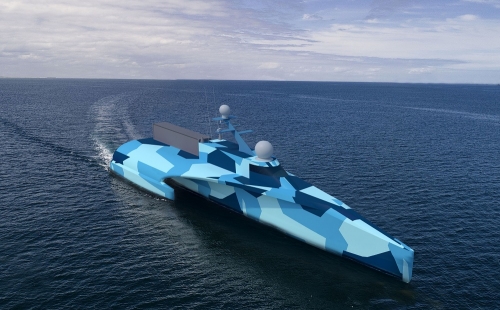

Le navire sans équipage Ghost Fleet Overlord a récemment parcouru 4700 miles nautiques avec succès et a participé à l'exercice Dawn Blitz, où il a opéré de manière autonome pendant presque tout le temps.

Ceux qui s'inquiètent de la puissance croissante de la Chine proposent d'utiliser de tels systèmes pour toutes les relations futures avec l'APL: utiliser des drones suicide sous-marins pour attaquer les sous-marins chinois, par exemple. Les États-Unis parlent déjà de robots de combat sous-marins et de surface qui seraient en cours de développement par l'armée chinoise et que les Chinois appellent une "Grande Muraille sous-marine". C'est pourquoi ils suggèrent d'établir une parité avec les Chinois ou de les surpasser d'une manière ou d'une autre.

Les efforts de la Chine dans ce domaine montrent que la disponibilité de nouveaux types d'armes ne donne aux États-Unis aucune garantie que ces systèmes ne seront pas mis en service par d'autres pays. Par exemple, l'apparition de drones de combat dans un certain nombre de pays a obligé les États-Unis à développer des méthodes et des stratégies pour contrer les drones.

Ainsi, en janvier 2021, le département de la défense américain a publié une stratégie pour contrer les petits systèmes d'aéronefs sans pilote : cette stratégie s'alarme de l'évolution de la nature de la guerre et de la concurrence croissante, qui constituent toutes deux des défis pour la supériorité américaine.

Le lieutenant général Michael Groen, directeur du Joint Artificial Intelligence Center du ministère américain de la défense, évoque la nécessité d'accélérer la mise en œuvre de programmes d'intelligence artificielle à usage militaire. Selon lui, "nous pourrions bientôt nous retrouver dans un espace de combat défini par la prise de décision basée sur les données, l'action intégrée et le rythme. En déployant les efforts nécessaires pour mettre en œuvre l'IA aujourd'hui, nous nous retrouverons à l'avenir à opérer avec une efficacité et une efficience sans précédent".

Le lieutenant général Michael Groen, directeur du Joint Artificial Intelligence Center du ministère américain de la défense, évoque la nécessité d'accélérer la mise en œuvre de programmes d'intelligence artificielle à usage militaire. Selon lui, "nous pourrions bientôt nous retrouver dans un espace de combat défini par la prise de décision basée sur les données, l'action intégrée et le rythme. En déployant les efforts nécessaires pour mettre en œuvre l'IA aujourd'hui, nous nous retrouverons à l'avenir à opérer avec une efficacité et une efficience sans précédent".

Le Centre interarmées d'intelligence artificielle du Pentagone, créé en 2018, est désormais l'une des principales institutions militaires développant des "logiciels intelligents" pour les futurs systèmes d'armes, de communication et de commandement.

L'intelligence artificielle est désormais le sujet le plus discuté au sein de la communauté de recherche de la défense américaine. C'est une ressource qui peut aider à atteindre certains objectifs, comme permettre aux drones de voler sans supervision, de recueillir des renseignements et d'identifier des cibles grâce à une analyse rapide et complète.

On suppose que le développement de l'intelligence artificielle entraînera une concurrence féroce, car l'IA elle-même se distingue de nombreuses technologies passées par sa tendance naturelle au monopole. Cette tendance au monopole exacerbera les inégalités nationales et internationales. Le cabinet d'audit Pricewaterhouse Coopers prévoit que "près de 16.000 milliards de dollars de croissance du PIB pourraient découler de l'IA d'ici à 2030", dont 70 % pour les seuls États-Unis et la Chine. Si la rivalité est le cours naturel des choses, alors pour les entreprises qui utilisent l'intelligence artificielle à des fins militaires ou pour des technologies à double usage, la considérer de cette manière semblera tout à fait logique. Il s'agira d'un nouveau type de course aux armements.

Sur le plan éthique, toutefois, les systèmes d'intelligence artificielle militaires pourraient être impliqués dans la prise de décisions visant à sauver des vies ou à prononcer des condamnations à mort. Ils comprennent à la fois des systèmes d'armes autonomes létaux, capables de sélectionner et d'engager des cibles sans intervention humaine, et des programmes d'aide à la décision. Certaines personnes plaident activement en faveur de l'inclusion de machines dans un processus décisionnel complexe. Le scientifique américain Ronald Arkin, par exemple, affirme que non seulement ces systèmes ont souvent une meilleure connaissance de la situation, mais qu'ils ne sont pas non plus motivés par l'instinct de conservation, la peur, la colère, la vengeance ou une loyauté mal placée, suggérant que, pour cette raison, les robots seront moins susceptibles de violer les accords de paix que les personnes.

Certains pensent également que les fonctions de l'intelligence artificielle peuvent transformer la relation entre les niveaux tactique, opérationnel et stratégique de la guerre. L'autonomie et la mise en réseau, ainsi que d'autres technologies, notamment la nanotechnologie, la furtivité et la biogénétique, offriront des capacités de combat tactique sophistiquées au sol, dans les airs et en mer. Par exemple, des bancs de véhicules sous-marins autonomes concentrés à des endroits précis de l'océan pourraient compliquer les actions secrètes des sous-marins qui assurent actuellement une frappe de représailles garantie par les puissances nucléaires. Par conséquent, d'autres plateformes tactiques pourraient également avoir un impact stratégique.

L'amélioration de la manœuvrabilité est également liée à l'intelligence artificielle. Celle-ci comprend, entre autres, des logiciels et des capteurs qui permettent aux robots d'être autonomes dans des endroits dangereux. C'est l'un des moteurs de l'utilisation de systèmes autonomes par l'armée. L'armée américaine fonde de grands espoirs sur l'autonomie des machines, car elle pourrait offrir une plus grande flexibilité aux personnes qui commandent et combattent aux côtés des robots. Les développeurs américains espèrent passer de 50 soldats soutenant un drone, un véhicule terrestre sans pilote ou un robot aquatique, comme c'est le cas actuellement, à un paradigme où une seule personne soutiendrait 50 robots.

Mais l'intelligence artificielle pourrait aussi créer de sérieux problèmes. L'intelligence artificielle militaire pourrait potentiellement accélérer le combat au point que les actions des machines dépassent les capacités mentales et physiques de ceux qui prennent les décisions dans les postes de commandement d'une guerre future. Par conséquent, la technologie dépassera la stratégie, et les erreurs humaines et de la machine se confondront très probablement - avec des conséquences imprévisibles et involontaires.

Une étude de la RAND Corporation, qui examine l'influence des machines à penser sur la dissuasion en cas de confrontation militaire, met en évidence les graves problèmes qui pourraient survenir si l'intelligence artificielle était utilisée sur le théâtre de la guerre. Sur la base des résultats des jeux réalisés, il a été démontré que les actions entreprises par une partie, que les deux joueurs percevaient comme ‘’désescalatoires’’, étaient immédiatement perçues par l'intelligence artificielle comme une menace. Lorsqu'un joueur humain retire ses forces afin de désamorcer une situation, les machines sont les plus susceptibles de percevoir cela comme un avantage tactique qui doit être consolidé. Et lorsqu'un joueur humain faisait avancer ses forces avec une détermination évidente (mais pas hostile), les machines avaient tendance à percevoir cela comme une menace imminente et à prendre les mesures appropriées. Le rapport a révélé que les joueurs devaient faire face à la confusion non seulement de ce que pensait leur ennemi, mais aussi de la perception de l'intelligence artificielle de leur ennemi. Les joueurs devaient également faire face à la façon dont leur propre intelligence artificielle pouvait mal interpréter les intentions humaines, qu'elles soient amicales ou hostiles.

En d'autres termes, l'idée contenue dans la pièce de Karel Čapek sur les robots est toujours d'actualité : il est impossible de prévoir le comportement de l'intelligence artificielle. Et si les robots "intelligents" ont un usage militaire, alors ils pourraient aussi devenir un danger pour leurs propriétaires. Même aux États-Unis, certains militaires sceptiques se rangent dans le camp des traditionalistes qui pensent que de telles innovations, imaginées par des utopistes de la Silicon Valley seront nuisibles à la politique de l'État américain.

00:33 Publié dans Actualité, Défense, Militaria | Lien permanent | Commentaires (0) | Tags : drones, ia, intelligence artificielle, technologie, cybernétique, cyber-technologie, robots |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook