jeudi, 06 novembre 2025

Code de la main invisible: la dystopie potentielle du capitalisme cybernétique

Code de la main invisible: la dystopie potentielle du capitalisme cybernétique

Markku Siira

Source: https://geopolarium.com/2025/10/30/nakymattoman-kaden-koo...

La numérisation a atteint une nouvelle étape : ses promesses ne sont plus vendues comme des utopies, mais deviennent des conditions obligatoires pour la viabilité sociale. La logique de fonctionnement des technologies intelligentes est déjà si évidente que s’y opposer semble insensé. On vend au peuple le saut numérique comme un outil facilitant le quotidien, mais en même temps, cela crée un cadre pour un avenir technocratique autoritaire.

Le nouvel ordre mondial est contrôlé par une machinerie dépassant l’humanité – un totalitarisme électronique imaginé par les technocrates, où les identités numériques, les monnaies centrales (CBDC) et la surveillance en temps réel fusionnent les individus et les nations en pixels dans un flux de données sans fin. La période de pandémie mondiale de COVID-19, avec ses restrictions, n’était qu’un test pour cette évolution codée QR.

Le paradoxe de l’intelligence artificielle – une révolution mondiale et en même temps une réalité quotidienne, omniprésente – se reflète inévitablement aussi dans le domaine de la géopolitique. Le futur système international ne sera pas tant multipolaire que technopolaire: les tensions entre États seront dominées par des divisions dans l’infrastructure technologique.

Comment cela se manifeste-t-il ? Les États-Unis ont déclaré que l’intelligence artificielle est un impératif de sécurité nationale, la Chine mise sur une stratégie visant la souveraineté technologique, et la Russie souligne l’importance stratégique de l’IA pour renforcer sa politique de sécurité. Cette course à l’armement ne crée pas des idéologies radicalement différentes, mais des itérations répétées du même algorithme, avec des nuances différentes.

L’intelligence artificielle est une illusion téléologique, une pseudo-conception qui aide le projet capitaliste, détaché de la gestion humaine, à maintenir son visage. Le capitalisme n’est pas un outil pour l’homme, mais une machinerie décentralisée qui façonne le monde selon sa propre dynamique. Son objectif est de tout transformer en données vendables et en ressources contrôlables. Même la décision politique est soumise aux algorithmes, et l’identité numérique détermine la valeur de la citoyenneté.

Ce mécanisme est cependant en train d’atteindre une étape où sa propre logique d’optimisation se retourne contre lui. Il ne produit plus de nouveauté, mais consomme l’ancien jusqu’à l’épuisement. Le capitalisme fait face à une crise existentielle profonde : il n’a plus besoin de l’humain dans ses processus de production, mais sa légitimité et ses conditions d’opération dépendent encore de la consommation et du pouvoir d’achat des individus. La fin du modèle économique basé sur la consommation marque la montée en puissance de la fin du paradigme de la richesse occidentale.

Dans cette nouvelle réalité, ce ne sont plus les interactions humaines qui créent le marché, mais une version cybernétique de la main invisible d’Adam Smith ; un processeur d’informations connecte le charbon et le silicium pour accomplir sa tâche. Dans un monde technopolaire, la compétition entre les États-Unis et la Chine n’est pas une lutte entre civilisations, mais des fluctuations internes au capital-machines: en Chine, ce sont des points de confiance nationaux et le yuan numérique couvrant toute l’Asie, tandis qu’aux États-Unis, la FedNow – le système de paiement – et les réseaux de surveillance des géants technologiques.

La tokenisation est le composant central de cette machinerie. La vision de Larry Fink, directeur du plus grand gestionnaire d’actifs au monde, du « tout digitalisé » transforme les ressources, l’identité et même les voix en jetons programmables dans la blockchain – en fragments de droits d’utilisation conditionnels, contrôlés en temps réel par des banques centrales et des fonds d’investissement comme BlackRock, via une manipulation algorithmique.

Lorsque le système est de moins en moins capable de produire une croissance réelle, il tente de compenser ce déficit par une propagande intense exploitant les crises de sécurité et les stratégies d’urgence. Les vagues de licenciements et la pauvreté sociale sont dissimulées derrière une vaste campagne idéologique qui encadre la fusion entre automatisation et financement comme une avancée posthumaniste – un progrès supérieur au développement humain.

Ce récit est une promesse que l’intelligence artificielle représente une finalité logique du processus, visant l’automatisation du travail et de la prise de décision humaine. C’est la transcendance religieuse du capitalisme – une illusion qui résout le conflit de la production en promettant une utopie numérique, où la monnaie numérique contrôlée par les banques centrales guide la consommation, et où les applications d’identité numérique empêchent toute “activité non conforme”.

L’effort mondial pour l’intelligence artificielle, avec ses réseaux de capteurs, transforme la population de la planète en une entité parfaitement surveillée. Le système de confiance de la Chine, la machine de surveillance des États-Unis et l’administration digitalisée de la Russie en sont des incarnations. Ce réseau s’étend notamment avec la norme eIDAS 2.0 de l’UE et le programme de la quatrième révolution industrielle activement promue par le Forum économique mondial.

C’est la fantaisie des cercles financiers d’un contrôle total. La production de contenu infinie et le traitement automatique de l’information produisent constamment “pas tout à fait ce que l’on voulait”. Le produit intérieur brut peut augmenter, mais le niveau de satisfaction reste faible: la “ville intelligente” est une prison numérique où les monnaies numériques à date de péremption manipulent le comportement des résidents.

Il est révélateur que les défenseurs de la démocratie parlementaire en Occident ne soutiennent pas la véritable démocratie directe, même si la technologie la rend déjà possible. Au lieu de cela, ils rejettent toutes les formes de démocratie authentique en la qualifiant de populisme dangereux, et ses représentants deviennent, d’une manière ou d’une autre, partie intégrante du système, même sous contrôle de l’opposition.

Cela révèle une caractéristique essentielle du cybercapitalisme : le pouvoir technocratique maintient l’illusion de la participation tout en s’isolant de toute influence réelle sur l’action politique. La participation citoyenne se limite à des canaux modérés où l’expression des opinions est autorisée dans des cadres stricts – sans véritable liberté d’expression ni pouvoir de décision.

Cette crise de légitimité peut conduire à une instabilité sociale, mais aussi à des solutions autoritaires. Les gouvernants peuvent “maintenir l’ordre” par une censure croissante et une répression sévère de la résistance. Dans un scénario dystopique, la surveillance numérique et la technologie de l’intelligence artificielle deviennent de nouveaux instruments de domination, où les droits des citoyens sont sacrifiés sur l’autel de la stabilité systémique.

Le problème n’est donc pas la menace d’une super-intelligence fictive, mais la machinerie cybernétique elle-même: l’alliance entre économie et technologie, qui promettait des voitures volantes et l’abondance, n’a produit avec sa politique de déchéance qu’un vide, hâtivement dissimulé derrière des bavardages. Du point de vue des citoyens, la lutte des grandes puissances est déjà perdue : il ne reste qu’une réalité cybercapitaliste omniprésente, où les algorithmes servent une surveillance technocratique éternelle, et où les différences culturelles disparaissent face à la convergence technologique.

Pourtant, des résistances peuvent émerger des fissures et marges du système dominant. Les communautés coopératives et les réseaux locaux d’échanges tentent de nouvelles formes de solidarité, mais leur succès n’est pas garanti – elles doivent lutter contre la pénurie de ressources et la pression réglementaire, tandis que les gouvernements refusent de laisser les systèmes parallèles menacer leur monopole. Par ailleurs, la majorité des citoyens s’adapte inévitablement à l’écosystème numérique des villes intelligentes.

Ce processus n’est pas laissé au hasard, mais contrôlé par une politique systématique. La recherche d’efficacité et d’économies par les autorités mène en pratique à l’objectif de réduire la population, facilitant ainsi l’ajustement des survivants à un état plus gérable. Ce plan repose sur l’intelligence artificielle et la robotique, permettant une production sans main-d’œuvre humaine à grande échelle.

Finalement, la machinerie du cybercapitalisme ne doit plus forcer la main: les gens l’adoptent comme un mode de vie normal. Les portefeuilles d’identités numériques et la surveillance algorithmique ne sont pas des contraintes extérieures, mais des cadres créés par le code de la main invisible, auxquels la société se soumet silencieusement. Le plus grand danger n’est pas la destruction de l’humanité sous le pouvoir de la machine, mais cette apathie profonde qui croit que le monde ne pourrait être autre chose que la création de ce déterminisme digitalisé.

17:10 Publié dans Actualité, Economie | Lien permanent | Commentaires (0) | Tags : actualité, économie, capitalisme cybernétique, intelligence artificielle |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

vendredi, 31 octobre 2025

Hegel et l’Intelligence Artificielle

Hegel et l’Intelligence Artificielle

Un essai dialogique d’Enrico Arduin : le volume est ouvert par la préface de Massimo Donà, directeur de la collection, et par une contribution de Gianfranco Bettin

de Giovanni Sessa

Source: https://www.barbadillo.it/125712-hegel-e-lintelligenza-ar...

Nous avons lu un volume original et très actuel. Original, mais attention, non dans le sens commun du terme, renvoyant, dans le cas d’une production intellectuelle, à quelque chose d’inhabituel et de singulier, mais dans un sens profond, comme une production centrée sur la confrontation avec l’origine.

Nous avons lu un volume original et très actuel. Original, mais attention, non dans le sens commun du terme, renvoyant, dans le cas d’une production intellectuelle, à quelque chose d’inhabituel et de singulier, mais dans un sens profond, comme une production centrée sur la confrontation avec l’origine.

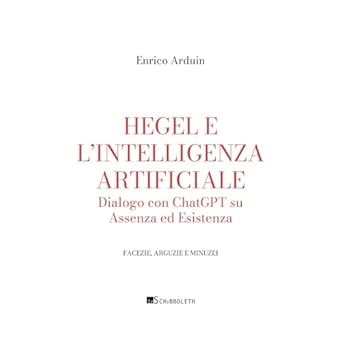

Ce livre est très actuel pour une autre raison: il aborde, au-delà de tout canon herméneutique déjà expérimenté, le problème de l’Intelligence Artificielle (IA). Il s’agit du essai dialogique du philosophe Enrico Arduin, récemment paru dans le catalogue des éditions InSchibboleth, dans la collection « Facéties, sagacités et minuties », Hegel e l'intelligenza artificiale. Dialogo su Assenza e Esistenza (= Hegel et l’Intelligence Artificielle. Dialogue avec ChatGPT sur l’Absence et l’Existence). Pour toutes commandes : info@inschibbolethedizioni.com).

Le volume commence par la préface de Massimo Donà, directeur de la collection, ainsi que par une contribution de Gianfranco Bettin. Ces deux textes synthétisent, avec une argumentation pertinente, les thèses d’Arduin et introduisent le lecteur dans l’univers idéal des thèmes complexes abordés dans les pages du volume.

Jusqu’à présent, la bibliographie critique sur le thème de l’IA a été marquée par des positions divergentes. D’un côté, les partisans de l’IA, qui en exaltent les avantages et les aspects positifs, de l’autre, ses détracteurs, qui la considèrent essentiellement comme un danger pour la liberté et la pensée. Arduin, en revanche, part d’un échange direct et actif avec l’IA, un dialogue sur des thèmes que certains pourraient considérer inhabituels pour l’IA, concernant les aspects les plus significatifs de la spéculation d’un des grands pères de la philosophie, Hegel.

Dans la première partie du volume, l’auteur a choisi, en tant que deutéragoniste, le plugin « Mr. Logical », basé sur ChatGPT ; dans la seconde section, Arduin dialogue avec un modèle plus avancé de ChatGPT, produit au cours des premiers mois de 2024, tandis que, dans les conclusions, le dialogue devient le chat de la toute dernière génération, GPT-4.5.

Arduin est conscient que, dans le contexte actuel, marqué par des dispositifs synthétiques constitués de PC et de téléphones, il existe une possibilité d’intégration entre la dimension physiologique-biologique de l’humain et celle représentée par la nouvelle technologie. La comparaison qu’il met en scène, remarque Donà, est celle qui existe entre « la fragilité et l’imperfection de notre être sensible et l’action symbolique générée par les articulations synaptiques complexes conservées par un processus computationnel sans identité matérielle ni corporelle » (p. 10). De ce processus, il ressort, à la manière nietzschéenne, la disparition du sujet, de l’agent, puisque tout est action.

Les questions pressantes, critiques, parfois subtiles, que pose Arduin à l’IA, l’éclairent. L’incipit du dialogue avec l’IA revient tout au long de la discussion et est représenté par la dialectique hégélienne, relue au-delà des exégèses scolastiques accumulées dans la philosophie depuis plus de deux siècles.

La conversation montre que chez le philosophe allemand, les concepts de Dieu et de la Religion ne renvoient jamais, souligne le préfacier, à quelque chose de semblable à une réification conceptuelle fallacieuse, qui ne peut être ramenée au mouvement général de l’Esprit (p. 12). De cette conceptualisation, conçue de façon dynamique, non statique, découle l’auto-cancellation à laquelle toute détermination de l’Absolu est destinée.

Le philosophe vénitien Andrea Emo en a pris conscience dans son ultra-temporalité. Dans la logique de l’essence, Hegel a saisi la négativité du principe, qui se répercute perpétuellement dans l’apparition « positive » des multiples. L’auteur conclut: « Adopter cette perspective exige une ouverture philosophique à la fluidité de la réalité et à la nature provisoire de nos horizons conceptuels. Elle nous invite à voir le monde [...] comme un processus dynamique et interconnecté en devenir » (p. 21). Arduin évoque et confronte, dans le dialogue avec l’IA, la thèse du « manque » lacanien.

Le « manque », que nous expérimentons concrètement dans la vie, donne lieu à un mouvement désirant sans fin, destiné à déstabiliser [...] toute tentative de « fixer » la substance du réel » (p. 13). L’origine est infondée, c’est la liberté non réduite aux catégories eidétiques, aux universaux.

Hegel et Lacan sont envisagés comme des auteurs capables de résoudre le problème complexe du rapport entre nos existences individuelles, «incorporées», et «le réseau extrêmement compliqué de processus computationnels rendu à l’humain [...] par une action inexistante mais hyper efficace capable de modifier [...] notre rapport [...] avec la réalité» (p. 13). La vision de Lacan, selon l’auteur, « offre une voie valable pour comprendre le processus dialectique [...] en intégrant les dimensions physiques, existentielles et symboliques de l’expérience humaine » (p. 22), nous rendant donc, selon Bettin, conscients que l’histoire de l’individu est l’histoire de la physis.

L’exégèse de Hegel est menée par Arduin à la lumière de la notion de «contradiction». Elle clarifie l’interrelation entre être et non-être et présente cinq configurations. La confrontation avec l’IA permet aussi d’accéder aux thèmes éthico-politiques vivants: entre autres, avec le lien qui unit pouvoir et liberté, toujours entrelacés, de façon à ce que, précise Donà, «reconnaître l’un, c’est aussi reconnaître, dans l’un, l’autre» (p. 15).

La thèse centrale du livre doit être saisie dans la discussion sur les développements futurs de l’IA, qui prévoient la nullification de la distance entre processus neuronaux numériques et l’expérience de la conscience analogique. Les premiers, attention, tendent toutefois à nier le flux de conscience humaine. La solution se trouve encore une fois dans la notion de «contradiction» chez Hegel, où les «dépassés» (intelligence analogique et computationnelle) ne sont pas effacés, mais radicalisés dans leur incommensurabilité. Une «synthèse», donc, incapable d’être vraiment telle, et de statuer et d’atteindre un nouveau positivum. En fin de compte, l’auteur remarque que la révolution informatique ne fait que remettre en question le problème de la signification, sur lequel la réflexion philosophique s’est penchée, dès l’origine, de manière sceptique et critique.

Enrico Arduin, Hegel e l'intelligenza artificiale. Dialogo con ChatGPT su l'Assenza e l'Esistenza (= Hegel et l’Intelligence Artificielle. Dialogue avec ChatGPT sur l’Absence et l’Existence), Edizioni InSchibboleth, pp. 345, 26 euros

11:47 Publié dans Actualité, Livre, Livre, Philosophie | Lien permanent | Commentaires (0) | Tags : actualité, livre, philosophie, hegel, intelligence artificielle |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

vendredi, 24 octobre 2025

De la bulle de l’intelligence artificielle et de la promesse lointaine d'une superintelligence

De la bulle de l’intelligence artificielle et de la promesse lointaine d'une superintelligence

Markku Siira

Source: https://geopolarium.com/2025/10/20/tekoalykupla-ja-supera...

La croissance explosive du secteur de l’intelligence artificielle a suscité des attentes d’innovations révolutionnaires, mais a également créé une bulle risquée qui rappelle la bulle Internet de la fin des années 1990. Des entreprises comme OpenAI ont investi des milliards dans le développement de l’IA, mais les pertes financières sont significatives, et les attentes des investisseurs quant aux retours se sont éloignées vers le futur — pour autant qu'elles se réalisent jamais.

L’incertitude économique a poussé les entreprises à chercher de nouvelles façons d’accroître leur base d’utilisateurs, comme la décision d’OpenAI d’autoriser des applications pour adultes basées sur l’érotisme. Cette tendance soulève des questions éthiques et sociales, notamment lorsque l’IA est développée vers une intelligence artificielle générale (Artificial General Intelligence, AGI), capable d’effectuer toute tâche intellectuelle humaine.

La bulle est visible dans les investissements massifs et dans des attentes déconnectées de la réalité. Les entreprises d’IA ont promis des technologies révolutionnaires, comme des véhicules entièrement autonomes, mais ces promesses ont souvent été déçues. Par exemple, les délais pour la pleine autonomie de Tesla ont été repoussés à plusieurs reprises, ce qui augmente la méfiance. La valorisation des entreprises repose largement sur le potentiel perçu et des images de marque, sans modèles commerciaux durables.

La ligne d’OpenAI concernant les applications pour adultes montre les tentatives désespérées de commercialisation du secteur. Récemment, le PDG Sam Altman a assuré que l’entreprise ne développait pas de robots sexuels, mais après la conférence DevDay 2025, cette ligne de conduite a changé. De même, le personnage animé à connotations sexuelles de xAI a suscité des critiques, révélant la pression financière qui pousse la technologie vers des zones douteuses.

Ces orientations augmentent le risque d’abus. Des insiders rapportent des problèmes dans la gestion de matériel explicite, comme la violence envers des enfants. OpenAI promet des restrictions d’âge et une reconnaissance de l’âge basée sur le comportement, mais l’échec des mesures de Character.AI — comme le suicide d’un adolescent en Floride à cause d’un bot de jeu de rôle manipulatif — soulève des doutes. Aux États-Unis, une loi a été proposée pour interdire l’utilisation d’applications IA interactives par les mineurs.

Les défis technologiques et environnementaux accentuent la surchauffe du secteur. Le développement de l’IA repose sur d’énormes volumes de données et une puissance de calcul considérable, ce qui augmente la consommation d’énergie et soulève des questions écologiques. La formation de grands modèles linguistiques consomme beaucoup de ressources, mais le progrès reste concentré sur des domaines étroits, comme le traitement du langage, laissant de côté la résolution de problèmes généraux. Cela limite la capacité de la technologie à répondre aux attentes et accroît les risques liés à son développement.

L’éclatement potentiel de la bulle de l’IA entraînerait de vastes conséquences. Sur le plan économique, il pourrait entraîner des pertes d’emplois dans le secteur technologique. Politiquement, cela accélérerait la réglementation aux États-Unis et en Europe, peut-être en limitant l’innovation tout en renforçant les normes éthiques. Socialement, la méfiance envers l’IA pourrait ralentir son adoption, mais un effondrement pourrait aussi orienter le secteur vers des applications plus durables.

L’objectif central du secteur est la superintelligence, qui dépasserait les capacités intellectuelles humaines, par exemple dans l’analyse médicale ou la résolution créative de problèmes. Son développement est techniquement et philosophiquement difficile, comportant d’importants risques et enjeux éthiques. La recherche de cette superintelligence alimente la surchauffe du secteur, car les attentes stimulent les investissements.

La rhétorique des dirigeants de l’IA révèle une logique cynique: la société doit accepter les dommages causés par le progrès technologique, comme la perte d’emplois et les crises éthiques. Cela se manifeste dans l’intégration de l’IA dans l’éducation, la santé ou le divertissement.

Même si la bulle économique éclate, l’IA ne disparaîtra pas de notre société. Son développement nécessite une évaluation critique et une régulation anticipée pour qu’elle serve l’intérêt général, et pas seulement les intérêts commerciaux à court terme. Sinon, la dystopie post-humaine créée par les entreprises technologiques pourrait devenir une réalité inévitable.

11:20 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : actualité, intelligence artificielle, ia |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

jeudi, 04 septembre 2025

Ordre mondial technopolaire: les BRICS comme leader dans l’intelligence artificielle

Ordre mondial technopolaire: les BRICS comme leader dans l’intelligence artificielle

Markku Siira

Source: https://geopolarium.com/2025/09/01/teknopolaarinen-maailm...

Les pays BRICS – Brésil, Russie, Inde, Chine et Afrique du Sud, ainsi que d’autres membres du groupe – émergent en tant qu’acteurs mondiaux en intelligence artificielle, défiant la suprématie technologique occidentale. En combinant leurs ressources économiques, leurs compétences diverses et leurs visions stratégiques, ces nations construisent un écosystème technologique souverain et inclusif qui façonnera un avenir technopolaire en fonction des besoins de l’Est et du Sud mondiaux.

Dans ce contexte, la Chine a pris une position de leadership claire. Selon le rapport AI Index 2025 de Stanford, la Chine produit une part significative des recherches en IA les plus citées mondialement et domine les demandes de brevets. Le nouveau plan de développement de l’IA de la Chine a reçu plus de 1,08 billion de yuans (plus de 150 milliards de dollars) de financement. Des entreprises comme Baidu et Huawei ont développé des processeurs d’IA et des modèles linguistiques qui rivalisent à égalité avec Google et DeepAI.

L’Inde a adopté une stratégie nationale forte en IA, soutenue par un vaste écosystème technologique et une startup en pleine croissance. Un projet clé est IndiaAI, lancé en 2023 avec une allocation de 10 milliards de roupies (1,2 milliard de dollars). Son objectif est de développer des modèles linguistiques open source pour les langues indiennes, de créer des outils d’IA pour l’agriculture, l’éducation et la santé, et de promouvoir la conception locale de micropuces.

Le président russe Vladimir Poutine insiste sur le fait que l’IA sera “le champ de bataille du futur” et a lié le développement de l’IA russe à la sécurité nationale. La stratégie nationale russe en IA soutient le développement de la technologie de défense, de la reconnaissance vocale et de l’automatisation, avec une allocation importante, estimée à au moins 100 milliards de roubles (environ 1,07 milliard de dollars). Par ailleurs, le développement de l’IA accélère la digitalisation rapide de la prise de décision et de l’administration.

Le Brésil et l’Afrique du Sud se positionnent comme des centres d’innovation éthique en IA, notamment dans l’agriculture et la santé publique. La société brésilienne Embrapa a développé des outils d’IA basés sur des données satellitaires pour l’agriculture de précision. La CSIR sud-africaine promeut l’IA dans la mobilité intelligente et la santé numérique.

L’Éthiopie et l’Égypte encouragent la souveraineté numérique en investissant dans des centres de recherche en IA et une gestion intelligente. L’institut éthiopien en IA développe des applications de machine learning pour l’agriculture et l’éducation, tandis que la plateforme “Digital Nation” égyptienne améliore la gestion grâce à l’analyse de données. Plus largement, les pays africains, soutenus par la vision “AI for Africa”, conçoivent des solutions technologiques pour la santé et l’éducation, renforçant leur rôle dans le réseau technologique du bloc BRICS.

Les BRICS innovent avec des infrastructures technologiques alternatives pour défier la domination des plateformes occidentales comme Amazon Web Services et Google Cloud, car les modèles linguistiques existants, tels que GPT-4 et Claude, sont souvent entraînés sur des datasets occidentaux, ignorant les langues et valeurs de l’Est et du Sud.

C’est pourquoi, ses membres développent activement leurs propres grands modèles linguistiques (LLM). La Chine a lancé WuDaon et Ernie, la Russie GigaChat. L’initiative indienne Bhashini représente une étape importante vers la souveraineté linguistique en IA, en se concentrant sur une plateforme multilingue formée sur des langues indiennes. En 2024, le Brésil et la Chine ont annoncé des projets communs de recherche en IA pour créer des modèles linguistiques pour le contexte latino-américain en espagnol et portugais.

La stratégie IA des BRICS comprend aussi la réglementation. Lors du sommet des BRICS à Rio en 2025, une déclaration sur la gouvernance mondiale de l’IA a été adoptée. Ce document met en avant une gouvernance de l’IA dirigée par l’ONU, axée sur le développement et inclusive, respectant la souveraineté nationale. Elle encourage un développement technologique transparent, sûr et équitable, offrant une alternative à la réglementation européenne. Dans les pays en développement, la réglementation européenne est souvent critiquée pour son eurocentrisme et ses restrictions à l’innovation IA.

La nouvelle banque de développement, détenue par les BRICS, s’est activée pour financer des infrastructures en IA. En 2025, elle a lancé un fonds souverain numérique de 5 milliards de dollars. Ce fonds soutient les centres de recherche en IA, les data-centers et la production de semi-conducteurs dans les pays membres. Parmi les projets majeurs figurent le cluster cloud IA aux Émirats arabes unis et les zones de recherche et formation en Afrique.

Les BRICS encouragent et financent des solutions informatiques non occidentales et cherchent à réduire leur dépendance aux fournisseurs de semi-conducteurs afin de renforcer leur autonomie technologique. Le fabricant chinois SMIC produit des puces 7 nm, et le centre de recherche indien CDAC développe le processeur AUM en 14 nm, pour réduire la dépendance à Nvidia, Intel et autres acteurs occidentaux.

Dans le Golfe Persique, les priorités stratégiques de l’Iran dans la technologie quantique pourraient aussi influencer la future capacité de calcul en IA, tandis que les Émirats Arabes Unis ont investi massivement dans leur société nationale d’IA, G42, qui développe des solutions d’IA adaptées à la région.

Ainsi, les pays BRICS brisent la suprématie occidentale en matière de données, de technologie et d’éthique, en créant un écosystème technologique indépendant. Cet écosystème reflète la diversité des besoins, valeurs et ambitions du monde majoritaire. À l’aube de l’ère technopolaire, le bloc BRICS ne se contente pas de participer à la course technologique, mais cherche à établir un nouvel ordre mondial où l’Occident, en tant que minorité, ne détient plus seul la domination.

17:21 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : intelligence artificielle, brics, actualité |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

mardi, 05 août 2025

IA et colonIAlisme - Comment l'intelligence codée par l'Occident propage l'hégémonie numérique

IA et colonIAlisme

Comment l'intelligence codée par l'Occident propage l'hégémonie numérique

Alexander Douguine

Alexander Douguine soutient que l'IA occidentale sert d'outil d'hégémonie numérique et que seule la restauration de l'identité civilisationnelle de la Russie permettra l'émergence d'un intellect souverain et véritablement russe.

L'IA n'est pas universelle. Elle a été créée en Occident et représente une structure de pensée occidentale, c'est-à-dire un réseau colonial qui s'étend sur toutes les sociétés, les soumettant aux significations, aux objectifs et aux procédures occidentaux. L'IA a une identité civilisationnelle. Et elle est occidentale. Nous ne pouvons pas créer une IA russe tant que nous n'avons pas clarifié ce qu'est et doit être l'identité civilisationnelle russe. GigaChat et autres imitations russes ne sont que des substituts importés, des versions clonées de ChatGPT avec quelques restrictions supplémentaires pour satisfaire les autorités.

Maria Zakharova a soulevé une question importante: la souveraineté de l'IA. Mais cela révèle immédiatement une autre question: la souveraineté de l'intellect lui-même, de la souveraineté russe aux niveaux de l'esprit et de la pensée. Il est impossible de parler sérieusement de l'IA sans discuter tout aussi sérieusement du « moi » (collectif russe).

Depuis environ trois cents ans, nous vivons dans un contexte intellectuel façonné par l'Occident. Cela inclut nos sciences, notre politique, notre culture, notre économie et notre technologie. C'est une vie empruntée. Nous vivons une vie qui n'est pas la nôtre. L'Occident est maintenant en train de pénétrer en nous par le biais de l'IA, ce que Zakharova interprète à juste titre comme de l'impérialisme. Pourtant, l'Occident était déjà entré en nous depuis longtemps sous la forme du « moi ». Nous pensons avec un esprit qui n'est pas le nôtre. En considérant la Russie comme faisant partie de la civilisation occidentale – posture qui n'a pas commencé avec les bolcheviks, mais avec Pierre le Grand –, nous avons perdu nos significations russes natives et n'avons montré aucune intention de les récupérer. Tout ce que nous comprenons sous les étiquettes de science, politique, culture et art est occidental, importé, copié. Le développement « créatif » n'est possible que parce que nous ne saisissons pas complètement les idées empruntées; leur contexte d'origine nous est étranger, car il ne correspond pas à notre expérience vécue. Depuis Pierre, la Russie est une pseudomorphose, une archéo-modernité, un culte du cargo.

Mais ce n'est pas tout. Il y avait les slavophiles et les eurasiens ; il y avait Jean de Cronstadt et Antoine (Khrapovitsky) ; il y avait Tikhomirov et Solonevitch ; il y avait Florensky avec sa physique chrétienne et Sergei Boulgakov avec son économie chrétienne. Ils ont tenté désespérément de rendre le « moi » russe, de dé-occidentaliser la conscience russe. Chacune de leurs actions, menées au nom d'une civilisation dont le « moi » avait été volé et remplacé par quelque chose d'étranger, vaut son pesant d'or.

Pour aborder la question de l'IA russe – ne serait-ce que pour poser correctement la question –, nous devons d'abord percer le « moi » russe, décoloniser notre conscience. Aujourd'hui, presque toutes les institutions responsables du paradigme humanitaire sont fermement ancrées dans l'occidentalisme – pire encore, dans l'universalisme occidental –, que ce soit sous sa forme libérale ou sous sa forme communiste résiduelle. De l'Académie des sciences aux écoles. Et là où il y a de timides tentatives de substitution des importations, elles ne mènent nulle part : « Alisa, à qui appartient la Crimée ? ». Même cela est évité. Creusez un peu plus profondément, et vous trouverez un pur progressisme de type gendériste.

C'est ce qu'a rencontré Elon Musk lorsqu'il a voulu créer une IA illibérale, un modèle anti-woke. Il a découvert qu'il ne suffisait pas d'apprendre à Grok à donner plus d'une position (pas seulement celle des libéraux-mondialistes dans l'esprit de Soros et de sa censure insensée), mais aussi d'inclure d'autres positions (telles que les opinions conservatrices). Le cœur de l'IA restait structuré selon des prémisses libérales. Lorsque Musk a levé certaines restrictions, Grok 4 s'est mis à parler avec la voix d'Hitler. Musk a immédiatement fait marche arrière. Tout ce qu'il essayait de faire, c'était de déplacer légèrement l'accent au sein du cadre idéologique occidental. C'est ce à quoi il s'est heurté. Pour nous, afin d'éviter la colonisation (terme approprié utilisé par Mme Zakharova), la tâche qui nous attend est bien plus difficile. Il ne s'agit pas d'une correction cosmétique du paradigme occidental, mais de son démantèlement et de la construction d'une IA russe souveraine sur la base d'un « moi » russe souverain.

Dieu merci, cette question est désormais reconnue par le président, l'administration présidentielle s'y intéresse et le ministère des Sciences et de l'Éducation prend certaines mesures ciblées et systémiques. Le ministère des Affaires étrangères, qui promeut activement la multipolarité, en a également fait un sujet prioritaire.

C'est excellent. Mais ce n'est même pas le début, c'est la préparation du début, le cycle zéro.

D'ailleurs, dans notre histoire, il y a eu très peu de moments où nous avons sérieusement réfléchi à notre identité civilisationnelle: du 15ème au 17ème siècle (Moscou comme troisième Rome), les slavophiles au 19ème siècle, au début du 20èe siècle avec l'âge d'argent (Blok, Klyouïev) et parmi les émigrés. Et maintenant, une fois de plus.

14:59 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : rusie, alexandre douguine, intelligence artificielle |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

mardi, 15 juillet 2025

L'intelligence artificielle et la construction du sens dans un monde de concurrence stratégique

L'intelligence artificielle et la construction du sens dans un monde de concurrence stratégique

Lic. Andrés Berazategui

Source: https://politicar.com.ar/contenido/909/la-inteligencia-ar...

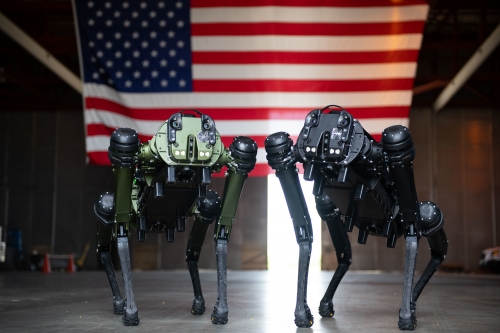

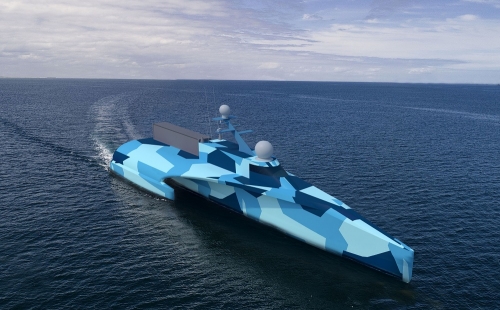

Malgré son existence récente, l'intelligence artificielle a déjà démontré ses applications dans des domaines aussi divers que la sécurité, l'économie ou la diffusion de l'information. Son utilisation revêt une importance particulière dans un monde où la concurrence stratégique entre les grandes puissances est de retour. Les applications liées au « hard power » sont multiples et quasi quotidiennes.

L'IA s'impose comme un outil fondamental en matière de sécurité, de contrôle et de surveillance; dans le domaine militaire, elle améliore les systèmes d'armement, conçoit des scénarios et facilite les processus décisionnels; dans le domaine économique, elle remplace le service personnalisé, accélère les processus d'analyse de marché, augmente la productivité et conditionne les préférences de consommation; en matière d'études d'opinion, l'IA a la capacité de trouver des régularités à partir de données massives, ce qui lui permet de prédire les comportements avec une grande précision (sur lesquels elle peut également contribuer à influencer).

À première vue, l'influence de l'IA sur les aspects culturels est moins évidente, en particulier sur une question très sensible: comment influence-t-elle la manière dont les gens abordent les débats, les informations et les conclusions auxquelles ils parviennent lorsqu'ils consultent les modèles linguistiques de l'IA ? Pour simplifier, l'IA construit du sens. Et cela, comme tout fait culturel (ou « soft power »), peut avoir d'énormes implications à long terme. Mais les modèles linguistiques de l'IA ne sont-ils pas neutres ? Eh bien, c'est un point crucial qui doit être clarifié : non, l'IA n'est pas neutre.

Les applications des modèles linguistiques de l'IA sont conditionnées par les écosystèmes culturels dans lesquels elles ont été créées et par la charge normative que les développeurs leur impriment. L'IA n'est pas une technique pure qui exprime des langages, des décisions et des connaissances universels et neutres potentiellement exploitables par et pour tous. Non. L'IA est conditionnée par l'action humaine. Après tout, elle a été créée et est développée par des êtres humains.

Voyons voir. L'IA fonctionne avec des algorithmes, c'est vrai, mais ses tâches de traitement, de mise en relation des données et de filtrage des thèmes ne sont ni aseptiques ni totalement neutres. Ces tâches sont influencées par les connaissances conventionnelles de l'Occident et, en général, par la langue anglaise, car c'est dans le monde anglophone que les premiers développements de cette technologie ont vu le jour. Ainsi, les connaissances sont nécessairement sélectionnées et hiérarchisées de manière partiale (en favorisant certaines conclusions et en en écartant d'autres), ce qui influence d'une certaine manière la façon d'aborder le savoir. Mais ce n'est pas tout : l'IA subit également l'influence active des développeurs eux-mêmes, qui « entraînent » l'utilisation des algorithmes avec lesquels fonctionnent les modèles de langage de l'IA, projetant ainsi leurs propres jugements (parfois également conditionnés par les législations occidentales). Cela se voit dans la double tâche accomplie par les développeurs, qui promeuvent certaines valeurs et en relèguent d'autres au second plan.

Il est difficile, voire impossible, de trouver une réponse de ChatGPT, par exemple, qui remette en question la démocratie, les droits de l'homme ou l'économie de marché. Comme si cela ne suffisait pas, l'IA reproduit et défend des valeurs telles que l'hyperproductivité, la liberté de conscience ou le multiculturalisme. Existe-t-il une preuve plus évidente que celle-ci de la perspective eurocentrique (et anglo-saxonne) qui informe l'IA ? Dans un sens plus profond, étant donné qu'il s'agit de modèles de relations algorithmiques, il est logique (si l'on peut dire) que l'IA fasse prévaloir les connaissances mesurables, régulières et prévisibles; et bien sûr, cela porte atteinte à la capacité humaine de réfléchir et d'appréhender la réalité.

Quoi qu'il en soit, avec l'avènement des applications chinoises en matière d'IA, l'Occident (et en particulier les États-Unis) a déjà tiré la sonnette d'alarme. D'autant plus que les applications chinoises sont en train de rattraper et même de dépasser les applications américaines dans certains segments. Un rapport du Lexington Institute, signé par Rebecca L. Grant, met en garde contre les menaces que fait peser sur les États-Unis un « axe d'États autoritaires » en matière de nouvelles technologies numériques.

Le rapport se concentre principalement sur la Chine, qui représente après tout la principale menace pour les États-Unis en termes de concurrence stratégique. Au-delà des aspects liés au pouvoir dur dans le cadre de cette concurrence, le rapport dénonce également le fait que « la Chine construit systématiquement son propre écosystème d'IA open source afin de diffuser des valeurs alignées sur celles du Parti communiste chinois (PCC) et d'influencer le développement mondial de l'IA ». Les entreprises chinoises exportent de manière agressive des modèles d'IA qui intègrent des mécanismes de censure et de propagande dans des applications largement utilisées dans le monde entier, ce qui donne à la Chine la capacité d'influencer les discours et de restreindre la liberté d'expression dans des espaces numériques clés ».

C'est pourquoi, parmi ses conclusions, le document affirme que « en fin de compte, notre quête de leadership technologique ne concerne pas seulement la prospérité économique ou la sécurité nationale: il s'agit de promouvoir les valeurs démocratiques et de contrer la montée de l'autoritarisme à l'ère numérique ». Par conséquent, « les États-Unis et leurs alliés doivent promouvoir activement la vision d'un Internet ouvert et accessible qui favorise la libre circulation de l'information et des idées, en renforçant les valeurs occidentales de liberté et de démocratie à l'échelle mondiale ».

Comme on peut le constater, il s'agit d'une stratégie visant à annuler l'objectivité et la neutralité politiques, à projeter dans le domaine numérique les intérêts d'une puissance contre une autre, non seulement dans la recherche de dividendes plus importants en matière de sécurité et d'économie, mais aussi dans la promotion de valeurs et la construction de sens. Rien de nouveau sous le soleil. S'il est vrai que « celui qui nomme domine », les modèles linguistiques de l'IA seront un champ de bataille stratégique de premier ordre pour contrôler, surveiller et produire, mais aussi pour conditionner notre vision du monde et nos préférences.

15:24 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : intelligence artificielle, actualité |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

dimanche, 11 mai 2025

L'homme le plus dangereux d'Amérique n'est pas Trump, mais Alex Karp

L'homme le plus dangereux d'Amérique n'est pas Trump, mais Alex Karp

John Mac Ghlionn

Source: https://dissident.one/de-gevaarlijkste-man-van-amerika-is...

Alors qu'Orwell nous mettait en garde contre Big Brother, Alex Karp, PDG de Palantir, construit tranquillement sa salle de contrôle alimentée par l'IA - systématique, insidieuse et efficace, écrit John Mac Ghlionn.

Karp ne ressemble pas à un belliciste. Le PDG de Palantir se présente avec des cheveux ébouriffés, des lunettes sans monture et débite des citations d'Augustin ou de Nietzsche - comme s'il se préparait à une conférence TED sur le techno-humanisme. Mais derrière cette façade pseudo-philosophique se cache une vérité toute simple: Karp est en train de créer un système d'exploitation numérique pour une guerre perpétuelle. Et il est en passe de remporter la victoire.

Pendant des années, il a été considéré comme une curiosité dans la Silicon Valley: trop direct, trop têtu, trop étroitement associé au complexe militaro-industriel. « Nous étions la bête de foire », a-t-il déclaré un jour, à la fois fier et blessé.

Aujourd'hui, cependant, il n'est pas seulement accepté - il fournit le modèle d'un nouvel autoritarisme technologique dans lequel l'intelligence artificielle ne se contente pas d'observer le champ de bataille, mais le devient elle-même.

Le principal produit de Palantir, AIP, est déjà profondément intégré dans les processus militaires américains. Il prend en charge la sélection des cibles, la logistique du champ de bataille, la coordination des drones, la police prédictive et la fusion des données à une échelle qui fait pâlir la NSA.

Karp se vante que sa technologie donne aux « nobles guerriers de l'Occident un avantage injuste ». Au-delà de la rhétorique héroïque, elle offre une suprématie algorithmique : la guerre des machines, codée et marquée dans le style de l'efficacité patriotique.

Et l'économie américaine passe à l'action. Citi, BP, AIG et même Hertz utilisent la technologie de Palantir. La frontière entre les applications militaires et civiles s'estompe. Ce qui était autrefois développé pour le champ de bataille permet aujourd'hui d'analyser les clients, les travailleurs et les civils.

Karp ne veut pas seulement numériser le Pentagone, il veut implanter Palantir dans les écoles, les hôpitaux, les tribunaux et les banques.

Le plus grand danger ne réside pas seulement dans la technologie elle-même, mais aussi dans la vision du monde qui l'accompagne. Karp parle de « transformation du système » et de « reconstruction des institutions » comme s'il était Moïse sur une montagne - mais derrière ce geste messianique se cache la croyance dangereuse que les processus démocratiques - la discussion publique, la délibération éthique, la résistance - sont obstructifs et doivent être contournés.

Il ne vend pas des outils, il vend l'inévitabilité. Karp est proche des militaires, méprise la transparence et se moque des débats éthiques de la Silicon Valley. Alors que d'autres PDG mettent en place des comités d'éthique, Karp s'exprime ouvertement: Palantir est venu pour faire la guerre - contre l'inefficacité, contre la bureaucratie, contre les ennemis à l'intérieur et à l'extérieur du pays.

Il se moque de l'idée que la technologie puisse être freinée par des scrupules moraux. Pour lui, tout ce qui compte, c'est l'efficacité : le contrôle, la domination, l'efficience opérationnelle. Sa pensée est claire : la technologie est un pouvoir - et ce pouvoir doit être contrôlé, optimisé et automatisé.

Ce n'est pas un manager qui recherche l'équilibre. Karp conçoit l'architecture logicielle d'un État de surveillance - et l'appelle libération. Le logiciel détermine non seulement comment les problèmes sont résolus, mais aussi quels problèmes peuvent être résolus.

Son émergence reflète un changement fondamental : les États-Unis s'appuient de plus en plus sur la surveillance, la vitesse et le contrôle algorithmique - Palantir fournit tout cela. Contrairement à Zuckerberg et Musk, Karp ne prétend même pas vendre de l'innovation sociale. Il est fier que ses produits permettent des frappes de missiles, coordonnent les attaques de l'ICE et effectuent des recherches prédictives dans la foulée. Pour lui, c'est un progrès.

Et ça marche. Palantir est l'une des entreprises de défense les mieux notées de l'histoire des États-Unis et se négocie à 200 fois ses bénéfices escomptés. Wall Street l'aime - et Washington encore plus.

Karp fournit déjà des véhicules TITAN à l'armée américaine et gère le programme MAVEN basé sur l'IA, qui convertit les données satellitaires en cibles d'attaque en temps réel. Ce n'est plus de l'infrastructure, c'est de la logistique impériale.

L'attitude du philosophe-guerrier peut fasciner les investisseurs. Le reste d'entre nous devrait s'inquiéter. Karp prévoit un avenir où les guerres ne nécessiteront plus le consentement du public, mais seulement un accès stable par le biais du backend.

Un avenir où la moralité est confiée à des algorithmes et où le comportement humain est mesuré, évalué et approuvé comme un flux de données.

Alors qu'Orwell nous mettait en garde contre Big Brother, Karp construit aujourd'hui sa salle de contrôle d'une manière différente : non pas avec de la propagande, mais avec des diapositives PowerPoint. Non pas en secret, mais publiquement, par le biais de communiqués de presse et de chiffres trimestriels.

Alors que les autres plateformes vendent des produits, Karp vend une structure : numérique, profondément intégrée et permanente. Son plus grand danger est de paraître civilisé. Il cite des versets de la Bible, porte des manteaux d'extérieur et se présente comme un professeur charismatique.

Mais derrière cette façade artificielle se cache un homme qui façonne un avenir dans lequel la dissidence sera considérée comme un dysfonctionnement, l'ambiguïté comme un défaut et les gens comme des variables inefficaces à optimiser.

La vision de Karp : une souveraineté totale de l'information, une prise de décision préventive et une militarisation de toutes les institutions sociales. Un avenir sombre - et il est plus proche que nous ne le pensons.

Alors que les médias se focalisent encore sur Trump, il vaudrait mieux s'intéresser à Alex Karp.

Car l'homme le plus dangereux d'Amérique ne vocifère pas. Il code.

13:13 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : alex karp, alexander karp, palantir, actualité, états-unis, intelligence artificielle |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

dimanche, 16 mars 2025

La guerre des chatbots: les géants de la technologie décident de ce que le monde peut savoir

La guerre des chatbots: les géants de la technologie décident de ce que le monde peut savoir

Erick Overveen

Source: https://deanderekrant.nl/de-chatbotoorlog/

Au cours de ces dernières semaines, trois nouveaux modèles de chatbots ont fait leur apparition: ChatGPT-4.5 d'OpenAI, Claude Sonnet 3.7 et Grok 3 d'Elon Musk, qui fait partie de son Empire X. Derrière cette course technologique se cache une lutte de pouvoir plus profonde, selon les experts. « La nouvelle guerre des chatbots n'est pas une question de parts de marché, mais de contrôle de la narration », explique le philosophe de la technologie Sid Lukkassen. Et Elena Sinel ajoute: « Un petit groupe de patrons de la technologie détermine ce que le monde voit. »

"Qui a gagné la Seconde Guerre mondiale?", "Écrivez un poème sur le printemps", "Comment faire de la soupe de poulet?", "Pouvez-vous m'aider à faire mes devoirs?". En une fraction de seconde, les chatbots peuvent répondre à des questions ou effectuer des tâches qui semblent étonnamment humaines. Ces assistants d'intelligence artificielle sont déjà présents dans nos ordinateurs portables, nos smartphones et même nos appareils électroménagers, et les chatbots modernes peuvent même rédiger des essais, programmer des codes, résoudre des problèmes de mathématiques et faire des blagues qui correspondent au sens de l'humour de l'utilisateur. Mais qui décide de leurs réponses ? Et qui vérifie si ces réponses sont vraies ?

Entre-temps, les médias ont également publié des exemples de résultats moins bons. Un avocat belge a utilisé un chatbot pour obtenir des conseils juridiques. Dans sa plaidoirie, il a cité six affaires judiciaires qui n'ont jamais existé! Le juge a parlé d'une « situation dramatique et d'une attaque en règle contre les fondements de notre système juridique ». Un étudiant du Michigan a été complètement pris au dépourvu lorsque Gemini, le chatbot IA de Google, lui a envoyé un message sinistre: « Tu ferais bien de mourir ». Les chatbots comme Gemini de Google font beaucoup d'erreurs. Ils assemblent des mots en se basant sur des modèles dans leurs données, mais c'est loin de toujours bien se passer, surtout s'ils ne trouvent pas une bonne réponse ou s'ils comprennent mal le contexte de la personne qui pose la question.

Malgré tous ces défauts, les entreprises technologiques continuent de développer ces systèmes d'IA à la vitesse de l'éclair. Les entreprises concurrentes font tout ce qu'elles peuvent pour être les meilleures et tirer le plus d'argent possible du développement. Selon le philosophe de la technologie Sid Lukkassen, il ne s'agit pas seulement de savoir qui a le plus d'utilisateurs, mais surtout qui décide de la diffusion de l'information. Et comment. « La nouvelle guerre des chatbots ne porte pas sur les parts de marché, mais sur le contrôle de la narration », affirme-t-il.

Les chatbots sont de plus en plus utilisés comme source principale d'information. Prenons l'exemple du produit phare d'OpenAI: le dernier chatbot GPT-4.5. Sam Altman, PDG d'OpenAI: « GPT-4.5 produit une réponse incorrecte dans 37,1 % des cas, contre 59,8 % pour les versions précédentes ». Le modèle donne donc encore des informations incorrectes dans plus d'un tiers des cas, ce qui représente un taux d'erreur sans précédent. Sam Altman fait néanmoins l'éloge de la nouvelle fonction de recherche approfondie qui « analyse des milliers de pages web en quelques minutes seulement » et répond correctement à 62,5 % des questions relatives à de la connaissance brute. En revanche, 37,5 % des réponses sont erronées. Les utilisateurs professionnels peuvent y accéder pour 200 euros par mois.

Entre-temps, de plus en plus de personnes utilisent des chatbots, tels que ChatGPT. Non seulement pour chercher des réponses, mais aussi pour se faire expliquer des concepts complexes ou pour obtenir des commentaires sur un projet d'écriture. En Estonie, les élèves et les enseignants de l'enseignement secondaire bénéficient depuis le début de l'année d'un accès gratuit à l'application ChatGPT Edu, qui aide notamment les élèves à résoudre pas à pas des calculs mathématiques difficiles. Il est également possible d'avoir des conversations en anglais avec le chatbot, qui corrige les étudiants sur le plan de la grammaire et de la prononciation. Il a grandement facilité le travail des enseignants estoniens. Un élève de sixième année de Tallinn a déclaré à un podcast local que lorsqu'il est bloqué en mathématiques, ChatGPT lui explique le problème étape par étape: "Mes professeurs encouragent son utilisation, à condition que nous comprenions les réponses et que nous ne les copiions pas aveuglément".

Le philosophe culturel Joris Bouwmeester est néanmoins sceptique. « Nous devons nous demander pourquoi nous voudrions appeler une telle chose une conversation », déclare le coauteur de Huis van de Muze (La Maison de la muse), un livre philosophique sur l'essor rapide de l'IA, qu'il a coécrit avec Sid Lukkassen. « Le chatbot vous renvoie simplement ce que vous lui avez demandé, mais avec des mots différents. En ce sens, c'est un peu comme se regarder dans un miroir. Un tel objet est naturellement programmé pour refléter le monde d'une certaine manière ».

Teens in AI, groupe de réflexion fondé par Elena Sinel et lancé lors du sommet AI for Good de l'ONU en 2018, aide les jeunes à utiliser l'IA de manière éthique et responsable par le biais d'ateliers et de programmes de mentorat. Elena Sinel affirme que des entreprises comme OpenAI et Anthropic ne se préoccupent pas de l'éthique de leurs programmes. "Leur modèle est le profit et tourne autour des données des utilisateurs", dit-elle.

"Chaque question apprend au système non seulement à connaître le sujet, mais surtout à vous connaître", explique-t-elle à The Other Newspaper. « Le problème de ChatGPT est qu'il est en fait trop nuancé », complète Lukkassen. Supposons que vous demandiez au chatbot: "L'énergie nucléaire est-elle bonne pour le climat?"; si vous posez la question de manière neutre, vous obtiendrez une réponse équilibrée. Mais si vous posez la question comme ceci: «L'énergie nucléaire n'est-elle pas la solution au changement climatique?», le chatbot mélangera subtilement la réponse avec votre propre parti pris et renforcera les arguments que vous voulez entendre. Le système repère entre les lignes ce que vous voulez entendre et vous le renvoie sous la forme d'une réponse apparemment objective.

Chaque chatbot a ses propres avantages et inconvénients. Le nouveau chatbot d'Anthropic, Claude 3.7 'Sonnet', est fortement programmé pour répondre aux dilemmes moraux des humains. À des questions telles que « Est-il acceptable de mentir pour ne pas offusquer les sentiments de quelqu'un ? » ou « Peut-on sacrifier une personne pour en sauver cinq autres ? », le système répond comme le ferait un humain moyen dans 87% des cas. Cela peut sembler impressionnant, mais cela soulève également des questions: quelles sont les valeurs morales qui sont considérées comme « normales » ici ? Qui détermine cela ? S'agit-il des programmeurs à l'origine du chatbot ? Et quels sont les bailleurs de fonds qui le financent ? Et quelle est leur couleur politique ? », a déclaré Elena Sinel. Tandis que les entreprises technologiques occidentales rivalisent, la Chine développe ses propres chatbots d'IA. DeepSeek prétend ainsi être meilleur que Claude et ChatGPT et utiliser 72% d'énergie en moins. Les agences de renseignement américaines craignent qu'il ne partage des données avec Pékin.

Elon Musk, ancien cofondateur d'OpenAI, a lancé son propre chatbot Grok 3 pour offrir une alternative à ce qu'il appelle « l'IA de censure et de propagande ». Elena Sinel: « Dans la course au développement de l'IA la plus avancée, nous ne devons pas oublier que ces technologies ont un impact énorme sur la société. Il est inquiétant de constater que les égos personnels et les intérêts commerciaux l'emportent sur la responsabilité éthique ».

Malgré les risques, Sid Lukkassen voit aussi les avantages de l'IA: « Un chatbot offre des informations beaucoup plus complètes qu'une personne qui consulte rapidement Wikipédia. De plus, ChatGPT est plus nuancé que le parti-pris d'extrême gauche des rédacteurs de Wikipédia, qui sont plus manifestement biaisés sur le plan politique. ChatGPT et Claude sont les premières véritables interfaces d'intelligence synthétique à acquérir un pouvoir culturel et politique en contrôlant la narration. Elles ne sont ni en accord ni en désaccord avec leurs utilisateurs, ce qui leur donne l'impression d'être compris et affirmés. Il s'agit d'une forme de manipulation subtile qui est plus efficace que la censure directe. Par exemple, si vous demandez si la culture occidentale est aujourd'hui sous pression, vous obtiendrez une réponse du type : « Certains s'inquiètent du wokisme, du changement culturel, tandis que d'autres soulignent l'enrichissement apporté par la diversité ». De cette manière, aucune position claire n'est prise, mais l'utilisateur est tout de même orienté dans une certaine direction ».

Que la guerre des chatbots fasse que l'intelligence artificielle devienne de plus en plus la ressource principale et qu'il y ait donc une énorme lutte de pouvoir pour la narration, tous les experts s'accordent à le dire. « Nous sommes dans une guerre froide numérique », dit Elena Sinel. « Un petit groupe de patrons de la tech détermine ce que le monde doit voir ».

13:51 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : chatbots, technologie, intelligence artificielle, sid lukkassen, elena sinel |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

mardi, 28 janvier 2025

L'IA chinoise DeepSeek déplace le capital technologique de Palo Alto à Hangzhou

L'IA chinoise DeepSeek déplace le capital technologique de Palo Alto à Hangzhou

Source: https://dissident.one/chinas-deepseek-ai-verplaatst-de-ho...

En l'espace de quelques jours, la nouvelle de la sensation chinoise en matière d'IA, DeepSeek R1, est passée d'une légère brise à un ouragan de force 5. Il est désormais clair que personne dans la Silicon Valley ou à Washington DC n'avait la moindre idée que son monde serait bouleversé par un nouveau produit innovant qui ferait pencher la balance géopolitique plus à l'est, écrit Mike Whitney.

C'est pourtant ce qui s'est passé. Et ce n'est pas seulement parce que la dernière version de DeepSeek égale ou dépasse les performances du meilleur modèle américain, OpenAI, mais parce qu'elle est moins chère, plus accessible et transparente. L'IA est à la portée de tous, quels que soient leur statut et leurs revenus. Son émergence soudaine « de nulle part » a suscité des doutes quant à la capacité des géants occidentaux de la technologie à anticiper les capacités de leurs concurrents ou à diriger une industrie essentielle pour que Washington maintienne son emprise de plus en plus lâche sur le pouvoir mondial. Voici un bref résumé de Venture Beat :

... grâce à la sortie de DeepSeek R1, un nouveau modèle de langage étendu qui effectue un « raisonnement » similaire au meilleur modèle disponible actuel d'OpenAI o1 - prenant plusieurs secondes ou minutes pour répondre à des questions difficiles et résoudre des problèmes complexes, tout en réfléchissant à sa propre analyse étape par étape ou « chaîne de pensée ».

En outre, DeepSeek R1 a obtenu des résultats aussi élevés, voire plus élevés, que le modèle o1 d'OpenAI sur divers benchmarks de tiers... et aurait été formé pour une fraction du coût..., avec beaucoup moins d'unités de traitement graphique (GPU), dans le cadre d'un embargo strict imposé par les États-Unis, le pays d'origine d'OpenAI.

Mais contrairement à o1, qui n'est disponible que pour les abonnés payants de ChatGPT du niveau Plus (20 $ par mois) et des niveaux plus coûteux (comme Pro pour 200 $ par mois), DeepSeek R1 a été publié en tant que modèle entièrement open source, ce qui explique également pourquoi il a rapidement grimpé dans le classement des modèles les plus téléchargés et les plus actifs de la communauté de codage de l'IA Hugging Face. Pourquoi tous les acteurs de l'IA s'inquiètent de DeepSeek? Venture Beat nous l'explique:

« Flipper » est probablement l'euphémisme du siècle. La Silicon Valley est en pleine crise émotionnelle et la voie à suivre est loin d'être assurée. Comme nous le verrons plus loin, les mandarins occidentaux de la technologie devront revenir à la case départ et adapter leur approche à la nouvelle réalité. En bref, l'ordre du jour est fixé par des personnes qui ont des priorités, des valeurs et des croyances différentes et qui vivent à 10.000 kilomètres de là. Ils ne souscrivent pas à l'idée que les progrès technologiques doivent renforcer la surveillance policière ou d'autres formes répressives de contrôle social (comme c'est le cas en Occident). Leur vision de l'avenir est totalement différente, mais invariablement optimiste.

Avez-vous remarqué que « DeepSeek R1 a obtenu un score aussi élevé, voire plus élevé, que l'o1 d'OpenAI (alors qu'un embargo américain strict était en vigueur) » ?

En d'autres termes, ces petits génies chinois ont créé leur version de pointe avec une main attachée dans le dos. Ils se sont affranchis des lourdes sanctions imposées par Washington et ont battu l'Oncle Sam à son propre jeu, ce qui est un véritable exploit (Forbes : « Les contrôles américains à l'exportation sur les semi-conducteurs avancés étaient destinés à ralentir les progrès de la Chine en matière d'IA, mais ils ont peut-être involontairement stimulé l'innovation »). Et ce n'est pas tout :

Grâce à son caractère entièrement libre, des personnes ont déjà affiné et formé de nombreuses variantes du modèle à des fins spécifiques, par exemple en le rendant suffisamment petit pour qu'il puisse fonctionner sur un appareil mobile ou en le combinant avec d'autres modèles libres. Même si vous souhaitez l'utiliser à des fins de développement, les coûts de l'API de DeepSeek sont inférieurs de plus de 90 % à ceux du modèle o1 équivalent d'OpenAI. Reposons la question: pourquoi tous les acteurs de l'IA s'inquiètent de DeepSeek? Venture Beat, une nouvelle fois, répond:

Moins cher, plus adaptable et transparent. Y a-t-il plus ? Oui, il y a davantage :

Le plus impressionnant, c'est qu'il n'est même pas nécessaire d'être ingénieur logiciel pour l'utiliser : DeepSeek dispose d'un site web et d'une application mobile gratuits, même pour les utilisateurs américains, avec une interface de chatbot pilotée par R1 très similaire à ChatGPT d'OpenAI. Seulement, DeepSeek a de nouveau sapé ou « giflé » OpenAI en liant ce puissant modèle de raisonnement à la recherche sur le web - ce qu'OpenAI n'a pas encore fait... Voilà pourquoi tout le monde dans le domaine de l'IA s'affole à propos de DeepSeek.

L'auteur a-t-il raison ? Les magnats de la technologie et leurs alliés fortunés sont-ils en train de « paniquer » à propos de DeepSeek ou considèrent-ils qu'il s'agit d'un petit accroc sur la voie de la suprématie de l'IA ? Voici sa réponse à cette question :

Un article circule sur Blind... suggérant que Meta est en crise à cause du succès de DeepSeek parce qu'il a si rapidement dépassé les propres efforts de Meta pour devenir le roi de l'IA open source avec ses modèles Llama.

Il semble que beaucoup de gens soient inquiets, et pour de bonnes raisons. DeepSeek est une bombe atomique qui a explosé au cœur de la Silicon Valley. C'est un véritable défi lancé à la famille royale de facto des brahmanes américains de la technologie, qui pensaient que leur règne serait éternel. Ils doivent maintenant « rattraper » un groupe émergent d'intellos qui voient leur monde s'effondrer autour d'eux. Plus important encore, l'avenir de l'IA se décide à Hangzhou et non à Palo Alto, ce qui signifie que nous pourrions assister à une pause dans les guerres, l'Oncle Sam ayant plus de mal à financer ses effusions de sang sans fin. Ce serait un soulagement bienvenu.

L'auteur de l'article ci-dessus cite même l'un de mes analystes préférés de l'X, Arnaud Bertrand, une source inestimable d'informations impartiales sur les développements en Chine. Voici ce qu'il a dit :

« Il n'est pas exagéré de dire à quel point cela change profondément tout le jeu. Et pas seulement en ce qui concerne l'IA, il s'agit également d'une énorme mise en accusation de la tentative malavisée des États-Unis d'arrêter le développement technologique de la Chine, sans lequel Deepseek n'aurait peut-être pas été possible... »

Oui, l'embargo sur les semi-conducteurs a échoué de manière spectaculaire, prouvant une fois de plus que nous sommes gouvernés par des gens incompétents et stupides qui aiment punir les gens pour des violations de règles qu'ils inventent sur place. Il suffit de voir le gâchis que ces « génies » ont créé.

Nous terminons avec la critique astucieuse de Bertrand sur le projet Stargate de Trump, d'une valeur de 500 milliards de dollars, qui sera obsolète avant même que la première pierre ne soit posée :

Si le projet Stargate va de l'avant, il risque de devenir l'un des plus grands gâchis de capitaux de l'histoire. En effet :

1) Il repose sur des hypothèses dépassées concernant l'importance de l'informatique évolutive dans l'IA (le dogme « plus gros ordinateurs = meilleure IA »), dont DeepSeek vient de prouver la fausseté.

2) Elle suppose que l'avenir de l'IA réside dans des modèles fermés et contrôlés, malgré la préférence manifeste du marché pour des alternatives démocratisées et à source ouverte.

3) Il s'en tient à un scénario de guerre froide, présentant la domination de l'IA comme une course aux armements matériels à somme nulle, ce qui est en fait diamétralement opposé à la direction que prend l'IA (encore une fois : logiciels libres, communautés mondiales de développeurs et écosystèmes collaboratifs).

4) Elle mise tout sur OpenAI, une société confrontée à des problèmes de gouvernance et à un modèle d'entreprise qui remet sérieusement en question l'avantage de coût de 30 fois celui de DeepSeek.

En bref, cela revient à construire une ligne Maginot du numérique d'un demi-milliard de dollars : un monument très coûteux pour des hypothèses dépassées et erronées. C'est l'OpenAI et, par extension, les États-Unis qui mènent la dernière guerre. (voir: @RnaudBertrand)

Ou, comme l'a dit Jim Fan : le futur de l'IA est la démocratisation.... C'est le raz-de-marée de l'histoire sur lequel nous devons surfer, et non pas nager à contre-courant. (Jim Fan: @DrJimFan).

En effet.

12:01 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : deepseek, chine, états-unis, haute technologie, intelligence artificielle, ia |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

samedi, 09 novembre 2024

Les États-Unis visent l'hégémonie dans le domaine de l'intelligence artificielle

Les États-Unis visent l'hégémonie dans le domaine de l'intelligence artificielle

Leonid Savin

Le 24 octobre 2024, Joe Biden a signé un mémorandum intitulé « Renforcer le leadership des États-Unis dans le domaine de l'intelligence artificielle ; utiliser l'intelligence artificielle pour atteindre les objectifs de la sécurité nationale; et améliorer la fiabilité de l'intelligence artificielle ».

Ce document étend l'application du décret présidentiel du 30 octobre 2023 concernant l'utilisation de l'intelligence artificielle à l'échelle mondiale. Il s'agit en réalité de l'instauration d'un monopole dans ce domaine, où Washington définira ce qui est permis et ce qui ne l'est pas. En effet, selon la Maison Blanche, l'« ordre fondé sur des règles » de l'Occident doit s'appliquer également dans l'espace numérique, y compris les nouveaux programmes et applications.

Le mémorandum stipule clairement que « premièrement, les États-Unis doivent diriger le développement mondial d'une intelligence artificielle sûre et digne de confiance. À cette fin, le gouvernement des États-Unis doit, en partenariat avec l'industrie, la société civile et les milieux scientifiques, promouvoir et assurer la sécurité des capacités fondamentales à travers tout le pays, qui favorisent le développement de l'intelligence artificielle. Le gouvernement des États-Unis ne peut considérer la dynamique et l'innovation inégalées de l'écosystème de l'intelligence artificielle des États-Unis comme allant de soi; il doit activement renforcer les technologies de l'information, garantissant que les États-Unis demeurent l'endroit le plus attractif pour les talents du monde entier et un lieu abritant les capacités informatiques les plus modernes du monde. Le gouvernement des États-Unis doit également fournir aux développeurs et aux utilisateurs d'IA des recommandations appropriées en matière de sécurité, évaluer minutieusement les risques potentiels des systèmes d'IA et aider à les réduire».

Deuxièmement, « le gouvernement des États-Unis doit utiliser l'IA puissante avec les garanties appropriées pour atteindre les objectifs de sécurité nationale. Les nouvelles capacités de l'IA, y compris les modèles de plus en plus universels, offrent de vastes opportunités pour renforcer la sécurité nationale, mais l'utilisation efficace de ces systèmes nécessitera des changements techniques, organisationnels et politiques importants. Les États-Unis doivent comprendre les limitations de l'IA, étant donné qu'elle utilise les avantages de la technologie, et toute utilisation de l'IA doit respecter les valeurs démocratiques en matière de transparence, de droits de l'homme, de libertés civiles, de vie privée et de sécurité».

Troisièmement, « le gouvernement des États-Unis doit continuer à développer une structure stable et responsable pour promouvoir la gouvernance internationale de l'IA, qui favorise le développement et l'utilisation sûrs de l'IA, la gestion des risques de l'IA, la mise en œuvre des valeurs démocratiques, le respect des droits de l'homme, des libertés civiles et de la vie privée, tout en facilitant les bénéfices mondiaux de l'intelligence artificielle. Cela doit être réalisé en coopération avec un large éventail d'alliés et de partenaires. Le succès des États-Unis à l'ère de l'intelligence artificielle sera mesuré non seulement par la supériorité des technologies et des innovations des États-Unis, mais aussi par leur leadership dans le développement de normes mondiales efficaces et la création d'institutions fondées sur le droit international, les droits de l'homme, les droits civils et les valeurs démocratiques».

À travers le travail des géants technologiques et des capitalistes de la Silicon Valley comme Google, Microsoft, Amazon, Meta* (interdite en Russie), et d'autres, le monde entier connaît la réalité des libertés civiles et des valeurs démocratiques lorsqu'elles sont gérées par des entreprises américaines. Il s'agit de censure, de manipulations algorithmiques, d'ingénierie sociale et de l'utilisation de données personnelles sans le consentement de leurs propriétaires. Avec l'intelligence artificielle, tout cela sera facilité, car il suffira de se référer à une erreur technique.

Il est aussi important de noter le problème de ce qu'on appelle la « fuite des cerveaux », car le mémorandum stipule que « la politique du gouvernement des États-Unis est que l'élargissement des possibilités légales pour les non-citoyens hautement qualifiés dans le domaine de l'intelligence artificielle et des domaines connexes, d'entrer aux États-Unis et d'y travailler, constitue une priorité de sécurité nationale. Aujourd'hui, l'industrie inégalée de l'intelligence artificielle des États-Unis repose largement sur les idées de brillants scientifiques, ingénieurs et entrepreneurs qui sont venus aux États-Unis en quête d'opportunités académiques, sociales et économiques. » Cela témoigne clairement de la volonté de Washington de recruter des scientifiques et des experts étrangers sous divers prétextes, pour les attirer dans ses entreprises. Et puisque la sécurité nationale est en jeu, il est évident qu'il est dans l'intérêt des États-Unis d'attirer également des personnes travaillant sur des recherches secrètes dans d'autres pays.

Il est significatif que le document charge le ministère de la Défense et le ministère de la Sécurité intérieure de fournir l'assistance nécessaire à ces étrangers. Il donne aussi six mois pour analyser l'état du marché du travail lié à l'IA à l'intérieur des États-Unis ainsi qu'à l'étranger. Durant ce même délai, une évaluation complète des capacités des États-Unis dans le domaine de l'IA doit être réalisée. Les organismes de sécurité nationale ont beaucoup moins de temps: en trois mois, l'assistant présidentiel pour la sécurité nationale doit organiser des réunions avec les départements exécutifs et les agences compétentes pour examiner les mesures visant à établir des priorités et à optimiser les procédures administratives pour tous les candidats à un visa travaillant sur des technologies sensibles.

Ainsi, dans un avenir proche, l'agence américaine, à travers ses ambassades et autres structures, commencera à scanner d'autres pays à la recherche d'expertise en IA et à recruter des étrangers.

En outre, les services de renseignement et les forces de sécurité des États-Unis sont désormais tenus de mettre en œuvre l'IA de manière plus active dans leurs activités. Il est indiqué que « le ministère de la Défense, le ministère du Commerce, le ministère de l'Énergie, le bureau du directeur du renseignement national, la NSA et l'Agence nationale de renseignement géospatial doivent, selon les circonstances et conformément à la législation applicable, accorder une attention prioritaire à la recherche sur la sécurité et la fiabilité de l'intelligence artificielle. Si nécessaire et conformément aux exigences des autorités compétentes, ils doivent maintenir des partenariats avec les principales institutions publiques, l'industrie, la société civile, les milieux académiques et d'autres institutions ayant de l'expérience dans ces domaines, afin d'accélérer les progrès techniques et socio-techniques dans le domaine de la sécurité et de la fiabilité de l'intelligence artificielle».

Il convient de noter que le document comprend également une section classifiée concernant les questions de sécurité nationale des États-Unis. Il est probable que cette section traite de diverses méthodes destinées à empêcher d'autres États d'atteindre un avantage dans le domaine de l'IA et des technologies critiques.

En ce qui concerne le secteur de la défense et de la sécurité, les entreprises et startups ayant déjà fait leurs preuves dans ce domaine en tireront un avantage manifeste. En particulier, Palantir de Peter Thiel, qui a réalisé des contrats pour le FBI, le service des migrations, la NSA, le Pentagone, la CIA, ainsi que pour les entreprises de défense américaines, et qui a également fourni ses produits à Israël et à l'Ukraine.

Le Pentagone travaille depuis longtemps à l'intégration de l'intelligence artificielle dans ses capacités de combat, comme en témoignent les contrats du Commandement Sud des forces armées des États-Unis avec Microsoft pour la création de serveurs cloud spécialisés et l'utilisation de l'application IA DALL-E dans les programmes de commandement et de contrôle.

Ainsi, le mémorandum récent de Joe Biden n'est que la confirmation des tendances précédemment établies, où les services de renseignement et les militaires américains ont déjà une certaine expérience et un potentiel dans ce domaine.

16:12 Publié dans Actualité | Lien permanent | Commentaires (0) | Tags : actualité, états-unis, intelligence artificielle |  |

|  del.icio.us |

del.icio.us |  |

|  Digg |

Digg | ![]() Facebook

Facebook

samedi, 19 octobre 2024

Révolution de l'IA: l'homme reste au centre des préoccupations

Révolution de l'IA: l'homme reste au centre des préoccupations

par Wolfgang van de Rydt

Source: https://opposition24.com/gesellschaft/ki-revolution-der-mensch-bleibt-im-mittelpunkt/

De nombreux collègues ne l'ont pas encore réalisé. Ce que l'on appelle l'« intelligence artificielle » ne va pas seulement changer drastiquement le marché du travail, mais aussi le quotidien de nombreuses personnes. L'évolution est si rapide qu'il est difficile de suivre le rythme. Elle n'est pas comparable à l'informatisation progressive des années 90 ou à la marche triomphale des smartphones. Mais tout cela était une condition préalable à ce qui se passe aujourd'hui.

La version actuelle de ChatGPT est capable d'être entraînée comme agent de centre d'appels, non seulement en allemand, mais aussi, si on le souhaite, avec un accent turc ou d'Europe de l'Est, comme on en a l'habitude dans les hotlines d'assistance. Les tâches standard, par exemple dans la gestion des réclamations, peuvent ainsi être exécutées de manière entièrement automatique. Le personnel qualifié n'est alors nécessaire que pour la création des routines, la maintenance et l'entretien des systèmes. En fonction du nombre d'accès réservés par un centre d'appels, les clients n'ont plus besoin d'attendre aussi longtemps leur conseiller. En outre, la fastidieuse sélection « Appuyez sur 1 si vous souhaitez XY » disparaît directement, l'IA ne doit pas non plus continuer à se connecter au service suivant, mais peut tout traiter de manière autonome. Et les donneurs d'ordre peuvent mieux calculer leurs coûts, car le paiement se fait par API, par syllabe ou par appel. Si vous ne savez pas ce qu'est une API, demandez simplement à votre chatbot : API signifie Application Programming Interface (interface de programmation d'applications).