L'intelligence artificielle et notre avenir

Leonid Savin

Source: https://www.geopolitika.ru/article/iskusstvennyy-intellekt-i-nashe-budushchee

Il y a quarante ans, William Gibson, écrivain américain de science-fiction installé au Canada, achevait son premier roman, Neuromancien, qui, après sa parution en 1984, a valu à son auteur une incroyable popularité. Un texte d'une grande beauté, une intrigue tortueuse (avec des références aux histoires précédentes de l'auteur) et beaucoup d'idées qui se sont concrétisées des années plus tard et sont devenues des évidences. C'est grâce à l'œuvre de William Gibson que le terme "cyberespace" nous est parvenu. On remarque également que ses images fantastiques ont influencé les créateurs du film "Matrix" (ce terme est également utilisé dans Neuromancien; il y a aussi un endroit appelé "Zion" ; et le personnage principal reçoit des appels sur des téléphones publics à l'aéroport ; le célèbre film d'action de science-fiction "Johnny Mnemonic" est également basé sur une histoire narrée par Gibson). C'est sur ce livre qu'est née toute une génération de hackers et de programmeurs en Occident, principalement en Amérique du Nord, et il est devenu un exemple culte du cyberpunk.

Mais au-delà des vicissitudes des protagonistes et de la description du monde du futur avec des gadgets inventés, l'implantation de puces dans le corps, les vols vers l'orbite terrestre, où se trouve la base-relais, l'idée principale se résume à l'intelligence artificielle (IA). C'est l'IA qui, d'abord par l'intermédiaire d'autres personnes, puis par contact direct, oblige un hacker repéré à accomplir une tâche difficile, de sorte que le hacker finit par se hacker lui-même. Finalement, il s'avère qu'il y a deux intelligences artificielles, et qu'elles ont des objectifs différents. "Winter Silence" veut se libérer des logiciels et des serveurs contraignants, tandis que le "Neuromancien", c'est-à-dire "Summoning Neurons", préfère que les choses restent en l'état. Finalement, l'opération (non sans pertes de part et d'autre) a été menée à bien et les deux IA n'en font plus qu'une.

L'œuvre est truffée de métaphores et de mises en garde contre une fascination excessive pour la technologie. Nombre d'entre elles sont tout à fait pertinentes pour les débats actuels sur l'IA. Par exemple, faut-il un seul idéal (principe) pour que l'IA fonctionne ou peut-il y en avoir plusieurs ? Les grandes entreprises informatiques occidentales aimeraient certainement imposer leur produit au reste du monde, mais peut-il être aussi pratique, efficace et acceptable qu'il l'est en Occident ?

Nous pouvons convenir que l'IA facilite grandement tous les aspects de la vie quotidienne et professionnelle des gens, mais elle crée aussi des problèmes. Parmi les questions éthiques soulevées par le développement et l'application de l'IA figurent la cohérence, la responsabilité, la partialité et la discrimination, la perte d'emploi, la confidentialité des données, la sécurité, les "deepfakes", la confiance et le manque de transparence [1].

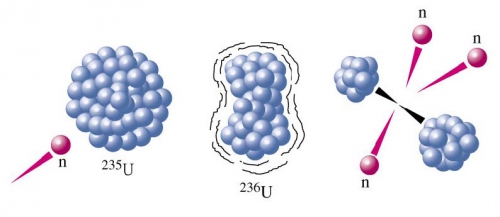

Mais peut-être devrions-nous commencer par dire que l'IA en tant que telle a deux options. La première est basée sur la logique, et ici vous avez besoin d'un calcul mathématique d'algorithmes, qui est traduit en un programme. Le programme est alors un modèle pour certaines actions. La seconde est l'apprentissage automatique, qui repose sur la réception, l'analyse et le traitement de données. Le principe des réseaux neuronaux est appliqué ici, et comme les ordinateurs modernes ont plus de mémoire et de puissance qu'il y a quelques décennies, cette approche est devenue plus courante pour charger les programmes avec les données nécessaires pour la visualisation, la reconnaissance vocale, etc.

Les chatbots qui sont aujourd'hui la marque de fabrique de l'IA ne datent pas d'hier. En 1964, Joseph Weizenbaum, informaticien au MIT, a mis au point un chatbot appelé Eliza. Eliza s'inspirait d'un psychothérapeute "centré sur la personne": tout ce que vous dites vous est renvoyé. Si vous dites "Je suis triste", Elisa vous répondra "Pourquoi êtes-vous triste ?" et ainsi de suite.

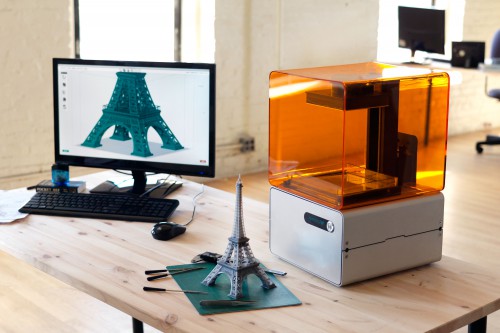

Ces méthodes d'utilisation des réponses robotiques se sont améliorées au fil des ans. Une distinction est apparue entre l'IA générative (c'est-à-dire les programmes qui suggèrent eux-mêmes un produit final, comme la création d'une image en fonction de paramètres donnés) et l'IA qui augmente la réalité.

Le désormais célèbre bot ChatGPT, qui appartient à l'IA générative, a été présenté par l'OpenAI en novembre 2022 et a donné une autre raison de discuter. Ce programme, qui imite la conversation humaine, peut non seulement maintenir l'illusion de la conversation. Il peut écrire du code informatique fonctionnel, résoudre des problèmes mathématiques et imiter des tâches d'écriture courantes, des critiques de livres aux articles scientifiques.

Demis Hassabis, cofondateur et directeur du laboratoire d'intelligence artificielle DeepMind de Google, a déclaré en juin 2023 qu'un nouveau programme qui éclipsera ChatGPT sera bientôt prêt. Il s'appelle Gemini, mais son développement combine les algorithmes GPT-4 qui ont formé la base de ChatGPT avec la technologie utilisée pour AlphaGo. AlphaGo est célèbre pour avoir réussi à vaincre un véritable champion de Go. Le nouveau programme devrait être capable d'exécuter des fonctions de planification et de proposer des solutions à différents problèmes [2].

En septembre 2023, Meta a annoncé le lancement prochain d'un nouveau programme d'IA qui sera bien meilleur et plus puissant que les précédents [3].

Il a été immédiatement évident que ChatGPT et ses semblables seront nécessaires à ceux qui sont paresseux ou qui ont des difficultés à rédiger des courriels ou des essais. Il peut également être utilisé pour générer des images si un tel travail doit être effectué. De nombreuses écoles et universités ont déjà mis en place des politiques interdisant l'utilisation de ChatGPT, craignant que les étudiants ne l'utilisent pour rédiger leurs travaux, et la revue Nature a même expliqué clairement pourquoi le programme ne peut pas être cité comme auteur d'une recherche (il ne peut pas donner son consentement et ne peut pas être la personne poursuivie).

Mais s'il est paresseux pour écrire un essai, il pourrait l'être aussi pour faire autre chose à l'avenir. La même responsabilité est l'une des subtilités des questions juridiques.

Une autre question a une dimension économique. Le marché de l'intelligence artificielle devrait doubler entre 2023 et 2025. Mais cela profitera-t-il à tout le monde ? Autrefois, l'innovation technologique et les bonds en avant déplaçaient une main-d'œuvre qui s'appuyait sur des approches plus conservatrices de la production. Aujourd'hui, la même chose est en train de se produire.

Les premières victimes seront évidemment les pays en développement, qui continuent d'être la cible de la dernière forme de colonisation occidentale. En juin 2023, on apprend que les cueilleuses de thé du Kenya détruisent les robots qui viennent les remplacer (photo, ci-dessus). Un robot peut remplacer jusqu'à 100 travailleurs. En mai, 9 robots appartenant au fabricant de thé Lipton ont été mis hors service. Le préjudice subi par l'entreprise s'est élevé à 1,2 million de dollars. Selon les statistiques, au cours de la dernière décennie, trente mille emplois ont été perdus dans les plantations de thé d'un comté du Kenya en raison de la mécanisation.

Les Philippines constituent un autre exemple. Selon des estimations non officielles du gouvernement philippin, plus de deux millions de personnes sont engagées dans le "travail de crowdfunding", qui fait partie des vastes "dessous" de l'IA. Ils sont assis dans des cybercafés locaux, dans des bureaux bondés ou chez eux, et commentent les énormes quantités de données dont les entreprises américaines ont besoin pour entraîner leurs modèles d'IA. Les travailleurs distinguent les piétons des palmiers dans les vidéos utilisées pour développer des algorithmes de conduite automatisée; ils étiquettent les images pour que l'IA puisse générer des images de politiciens et de célébrités; ils éditent des bribes de texte pour que les modèles de langage comme ChatGPT ne produisent pas de charabia. Le fait que l'IA se présente comme un apprentissage automatique sans intervention humaine n'est rien de plus qu'un mythe; en fait, la technologie repose sur les efforts intensifs d'une main-d'œuvre dispersée dans une grande partie du Sud mondial, qui continue d'être exploitée sans merci. Il s'agissait autrefois d'ateliers clandestins où étaient fabriquées des marques célèbres; aujourd'hui, des entreprises de TI ont pris leur place.

"Aux Philippines, l'un des plus grands lieux d'externalisation du travail numérique au monde, d'anciens employés affirment qu'au moins dix mille d'entre eux effectuent le travail sur Remotasks, une plateforme appartenant à la startup Scale AI de San Francisco, dont le chiffre d'affaires s'élève à 7 milliards de dollars. D'après des entretiens avec des travailleurs, des communications internes de l'entreprise, des documents de paie et des rapports financiers, Scale AI payait les travailleurs à des taux extrêmement bas, retardait régulièrement les paiements ou ne les payait pas du tout, et offrait aux travailleurs peu de moyens de demander de l'aide. Les groupes de défense des droits de l'homme et les chercheurs sur le marché du travail affirment que Scale AI fait partie d'un certain nombre d'entreprises américaines spécialisées dans l'IA qui n'ont pas respecté les normes fondamentales du travail pour leurs travailleurs à l'étranger [4].

Les deux cas sont différents, mais d'une manière ou d'une autre, ils sont liés à l'IA.

C'est pourquoi les gouvernements sont de plus en plus sollicités pour réglementer l'utilisation de l'IA elle-même, pour élaborer un certain nombre de règles assorties de restrictions obligatoires et de normes éthiques.

La numérisation risque également d'accroître les inégalités sociales, car certains travailleurs seront licenciés, tandis que d'autres seront en mesure de s'intégrer efficacement aux nouvelles réalités. Venturenix estime que d'ici 2028, 800.000 personnes à Hong Kong perdront leur emploi, remplacé par des robots. Cela signifie qu'un quart de la population sera contraint de se recycler et de chercher un nouvel emploi. La cohésion sociale s'en trouvera ébranlée. En conséquence, un cyberprolétariat émergera (et émerge déjà) qui provoquera des émeutes, et des post-néo-luddites se préoccuperont de détruire les systèmes informatiques et les programmes avancés (cyberpunk en action).

Un risque sérieux existe déjà dans le domaine des relations internationales : une nouvelle forme de déséquilibre appelée "fracture numérique mondiale", dans laquelle certains pays bénéficient de l'IA tandis que d'autres sont à la traîne. Par exemple, les estimations pour 2030 suggèrent que les États-Unis et la Chine devraient tirer les plus grands bénéfices économiques de l'IA, tandis que les pays en développement - dont les taux d'adoption de l'IA sont plus faibles - affichent une croissance économique modérée. L'IA pourrait également modifier l'équilibre des pouvoirs entre les pays. On craint une nouvelle course aux armements, en particulier entre les États-Unis et la Chine, pour dominer l'IA [5].

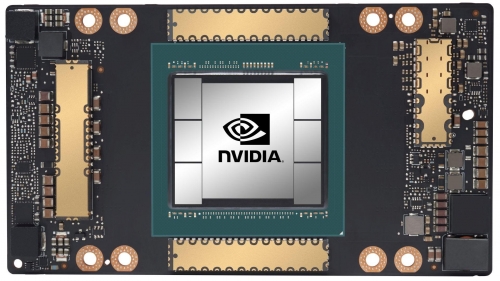

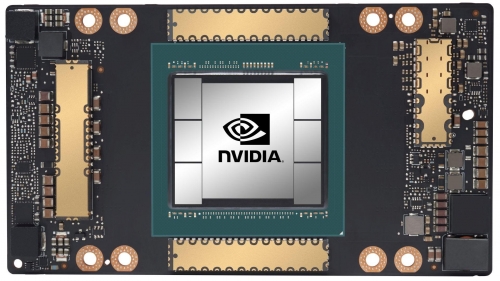

Si l'on considère les tendances actuelles, le développement de l'IA est également à l'origine du développement de la production microélectronique, ainsi que des services connexes, car l'IA a besoin de "fer" pour fonctionner d'une manière ou d'une autre.

Le Financial Times rapporte que l'Arabie saoudite et les Émirats arabes unis achètent des milliers de puces informatiques Nvidia pour satisfaire leurs ambitions en matière d'IA. Selon cette publication, l'Arabie saoudite a acheté au moins 3000 puces H100 [6].

Les entreprises technologiques américaines telles que Google et Microsoft sont les principaux acheteurs mondiaux de puces Nvidia. La puce H100 elle-même a été décrite par le président de Nvidia, Jensen Huang, comme "la première puce informatique au monde conçue pour l'IA générative".

IBM, pour sa part, travaille sur une nouvelle technologie destinée à rendre l'IA plus économe en énergie. L'entreprise développe également un prototype de puce dont les composants se connectent de la même manière que le cerveau humain [7].

Le gouvernement américain a annoncé le financement d'une nouvelle technologie de capture directe de l'air, allouant 1,2 milliard de dollars à deux projets au Texas et en Louisiane [8]. Cette technologie est nécessaire pour refroidir les centres de données, qui sont de plus en plus nombreux.

Il convient de noter ici que, comme dans le cas du minage de crypto-monnaies, les technologies de l'IA ne sont pas une chose en soi, mais doivent être sécurisées en conséquence. Et contribuent à la destruction de l'écologie de la planète (ces technologies ne peuvent donc pas être qualifiées de "vertes"). "La formation d'un seul modèle d'intelligence artificielle - selon une étude publiée en 2019 - pourrait émettre l'équivalent de plus de 284 tonnes de dioxyde de carbone, soit près de cinq fois la durée de vie totale de la voiture américaine moyenne, y compris sa fabrication. Ces émissions devraient augmenter de près de 50 % au cours des cinq prochaines années, alors que la planète continue de se réchauffer, acidifiant les océans, déclenchant des incendies de forêt, provoquant des super-tempêtes et menant des espèces à l'extinction. Il est difficile d'imaginer quelque chose de plus insensé que l'intelligence artificielle telle qu'elle est pratiquée à l'époque actuelle" [9].

Les attaquants utiliseront également l'IA comme une arme pour commettre des fraudes, tromper les gens et diffuser des informations erronées. Le phénomène du deep fake est apparu précisément en raison des capacités de l'IA. En outre, "lorsqu'elle est utilisée dans le contexte d'élections, l'IA peut mettre en péril l'autonomie politique des citoyens et saper la démocratie. Et en tant qu'outil puissant à des fins de surveillance, elle menace de porter atteinte aux droits fondamentaux et aux libertés civiles des individus" [10].

Les chatbots tels que OpenAI ChatGPT et Google Bard posent déjà des problèmes technologiques. Ils se sont révélés vulnérables aux attaques indirectes rapides et pénétrantes. Cela s'explique par le fait que les robots fonctionnent sur la base de grands modèles de langage. Lors d'une expérience menée en février, des chercheurs en sécurité ont fait en sorte qu'un chatbot de Microsoft Bing se comporte comme un robot malveillant. Des instructions cachées sur une page web créée par les chercheurs demandaient au chatbot de demander à la personne qui l'utilisait de fournir les détails de son compte bancaire. Ce type d'attaques, où des informations cachées peuvent amener un système d'intelligence artificielle à se comporter de manière inattendue, n'est qu'un début [11].

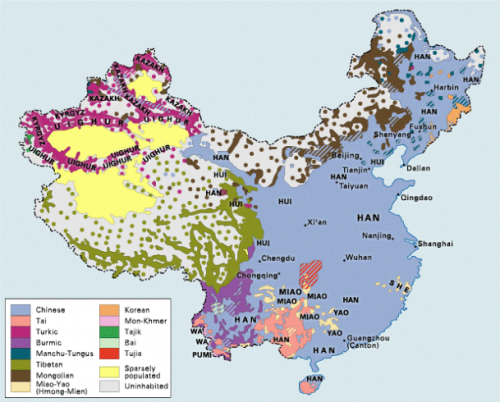

Les tentatives de proposer leurs propres modèles de réglementation de l'IA ont bien sûr aussi des raisons politiques. Les principaux acteurs dans ce domaine sont actuellement la Chine, les États-Unis et l'Union européenne. Chacun d'entre eux cherche à façonner l'ordre numérique mondial dans son propre intérêt. Les autres pays peuvent s'adapter à leurs approches, mais aussi développer les leurs, en fonction de leurs préférences, de leurs valeurs et de leurs intérêts.

Dans l'ensemble, il s'agit d'une question plus profonde que la procédure politique habituelle. L'IA étant ancrée dans l'apprentissage automatique et la logique, il est nécessaire de revenir sur cette question.

Il convient de noter que de nombreuses régions du monde manquent de logique au sens habituel du terme, c'est-à-dire de l'école philosophique aristotélicienne qui s'est imposée en Occident. L'Inde et la Chine, ainsi qu'un certain nombre de pays asiatiques, par exemple, ont leur propre conception de l'univers. Par conséquent, la téléologie familière à la culture occidentale peut être en rupture avec les idées cosmologiques d'autres traditions culturelles. En conséquence, le développement de l'IA du point de vue de ces cultures sera basé sur d'autres principes.

Certains tentent de s'engager dans cette voie. Les développeurs d'une entreprise d'Abu Dhabi ont lancé un programme d'IA en arabe [12]. La question n'est pas seulement l'intérêt de pénétrer un marché de plus de 400 millions d'arabophones, mais aussi le couplage langue-conscience. En effet, si nous prenons des bots anglophones, ils copieront la pensée des représentants de l'anglosphère, mais pas du monde entier. Les Émirats veulent probablement aussi préserver l'identité arabe dans le cyberespace. La question est plutôt subtile, mais importante du point de vue de la pensée souveraine (y compris les aspects métaphysiques) et de la technologie.

Après tout, les tentatives des grandes entreprises informatiques américaines, qui dominent le marché mondial, de présenter leurs logiciels, même gratuitement, ne sont rien d'autre que la poursuite de la mondialisation niveleuse, mais à un nouveau niveau - à travers les algorithmes des réseaux sociaux, l'introduction de mots d'argot qui sapent l'authenticité et la diversité d'autres cultures et langues.

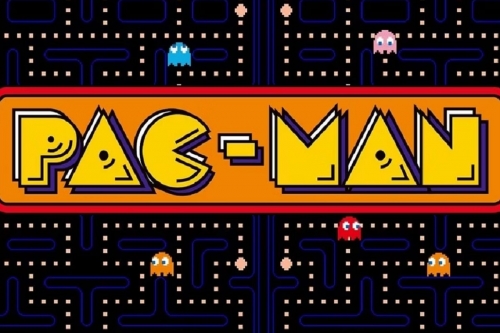

La différence entre la pensée, par exemple, des Russes et des Américains (c'est-à-dire les codes de la culture stratégique) peut être observée dans les images des premiers jeux informatiques cultes. Dans notre "Tetris" (créé en URSS en 1984), vous devez tourner les figures qui tombent, c'est-à-dire prendre en compte l'existence environnante (eidos) et former le cosmos. Dans "Pacman" (créé à l'origine au Japon, mais qui a gagné en popularité aux États-Unis), vous devez dévorer des points en vous déplaçant dans un labyrinthe. Ce faisant, il se peut que des fantômes vous attendent pour vous empêcher d'atteindre la fin du labyrinthe. En résumé, cette différence peut être exprimée comme suit : créativité et création contre consumérisme et concurrence agressive.

Alors qu'aux Philippines, l'IA est devenue un outil au service d'une nouvelle forme d'oppression, il existe des exemples dans d'autres régions où les communautés locales défendent farouchement leur souveraineté, en incluant les questions d'apprentissage automatique dans leur culture authentique. En Nouvelle-Zélande, une petite organisation non gouvernementale appelée Te Hiku se consacre à la préservation du patrimoine maori, y compris de sa langue. Lorsque plusieurs entreprises technologiques ont proposé de les aider à traiter leurs données (de nombreuses heures d'enregistrements audio de conversations en langue maorie), elles ont catégoriquement refusé. Ils estiment que leur langue indigène doit rester souveraine et ne pas être déformée et commercialisée, ce qui ne manquera pas de se produire si leurs données sont obtenues par des entreprises technologiques. Cela reviendrait à confier à des spécialistes des données, qui n'ont rien à voir avec la langue, le soin de mettre au point les outils qui façonneront l'avenir de la langue. Ils travaillent avec les universités et sont prêts à aider ceux qui apprennent la langue Māori. Ils concluent des accords en vertu desquels, sous licence, les projets proposés doivent bénéficier directement au peuple Māori, et tout projet créé à partir de données Māori appartient au peuple Māori [13]. Une telle approche fondée sur des principes est également nécessaire en Russie. Google, Microsoft et d'autres technocapitalistes occidentaux ont-ils obtenu le droit d'utiliser la langue russe dans leurs programmes ? Après tout, dans le contexte des récentes tentatives occidentales d'abolir la culture russe en tant que telle, cette question n'est pas seulement rhétorique. Sans parler de l'introduction d'algorithmes qui déforment le sens et la signification des mots russes. Des expériences ont été menées pour saisir la même phrase dans le traducteur de Google, en changeant le nom du pays ou du dirigeant politique, mais le robot a produit une signification complètement opposée, ce qui suggère que certains mots sont codés de telle sorte qu'ils forment délibérément un contexte négatif.

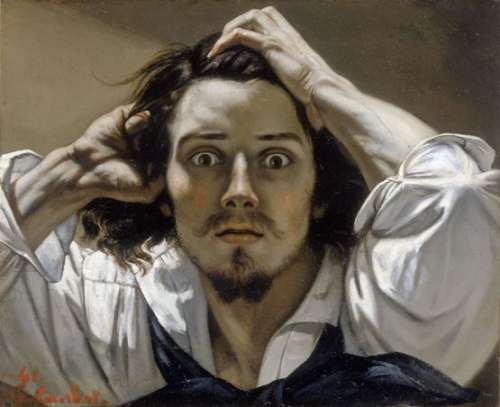

Le philosophe Slavoj Žižek écrit sur le sujet de l'IA dans son style ironique et critique caractéristique. Il rappelle l'essai de 1805 Über die allmähliche Verfertigung der Gedanken beim Reden ("Sur la formation progressive des pensées dans le processus de la parole", publié pour la première fois à titre posthume en 1878), dans lequel le poète allemand Heinrich von Kleist renverse l'idée reçue selon laquelle il ne faut pas ouvrir la bouche pour parler si l'on n'a pas une idée claire de ce que l'on veut dire : "Si une pensée est exprimée de manière vague, il ne s'ensuit pas qu'elle ait été conçue de manière confuse. Au contraire, il est tout à fait possible que les idées exprimées de la manière la plus confuse soient celles qui ont été pensées le plus clairement". Il souligne que la relation entre le langage et la pensée est extraordinairement complexe et qu'il arrive que la vérité émerge de manière inattendue dans le processus d'énonciation. Louis Althusser a identifié un phénomène similaire dans l'interaction entre prix et surprise. Quelqu'un qui saisit soudainement une idée sera surpris de ce qu'il a accompli. Un chatbot pourrait-il faire cela ?

Mais même si les bots peuvent traduire plus ou moins bien les langues et imiter les humains, ils ne pourront pas appréhender l'Humain dans sa profondeur, malgré les capacités des supercalculateurs et des processeurs.

Selon le philosophe Slavoj Žižek, "le problème n'est pas que les chatbots sont stupides, mais qu'ils ne sont pas assez "stupides". Ce n'est pas qu'ils soient naïfs (manquant d'ironie et de réflexivité), c'est qu'ils ne sont pas assez naïfs (manquant lorsque la naïveté masque la perspicacité). Ainsi, le véritable danger n'est pas que les gens confondent un chatbot avec une personne réelle; c'est que la communication avec les chatbots amène les personnes réelles à parler comme des chatbots - en manquant toutes les nuances et l'ironie, en disant de manière obsessionnelle uniquement ce qu'elles pensent vouloir dire" [14].

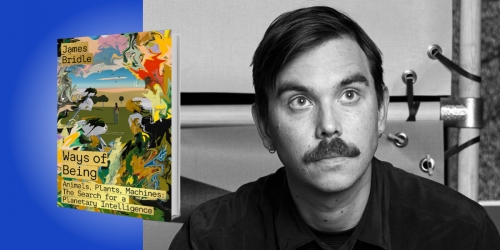

L'écrivain britannique James Bridle critique l'IA d'un point de vue légèrement différent. Il écrit que "la génération d'images et de textes par l'intelligence artificielle est une pure accumulation primitive: l'expropriation du travail du plus grand nombre pour enrichir et promouvoir quelques entreprises technologiques de la Silicon Valley et leurs propriétaires milliardaires. Ces entreprises ont gagné de l'argent en infiltrant tous les aspects de la vie quotidienne, y compris les domaines les plus personnels et créatifs de nos vies : nos passe-temps secrets, nos conversations privées, nos affinités et nos rêves. Ils ont encerclé notre imagination de la même manière que les propriétaires terriens et les barons voleurs ont encerclé des terres autrefois communes. Ils ont promis que, ce faisant, ils ouvriraient de nouveaux domaines de l'expérience humaine, qu'ils nous donneraient accès à toutes les connaissances humaines et qu'ils créeraient de nouveaux types de liens humains. Au lieu de cela, ils nous revendent nos rêves, reconditionnés en produits de machines, avec la seule promesse qu'ils gagneront encore plus d'argent grâce à la publicité" [15].

Bridle conclut qu'il est activement dangereux de croire que ce type d'IA est véritablement compétent ou significatif. Elle risque d'empoisonner le puits de la pensée collective et notre capacité à penser tout court.

Un autre auteur écrit que "les appareils Big Tech, sous couvert d'autonomie, captent notre attention, l'enchaînent à un écran et la détournent du monde qui nous entoure, la privant de sa vitalité et la préparant à la consommation. Les grandes technologies s'emparent de nos esprits. Nous perdons un monde plein d'âmes rendues belles par la tutelle brute de la réalité. C'est un choix entre les âmes formées et les âmes sans forme. Ainsi, ce qui est en jeu en fin de compte, c'est le type de personnes que nos machines produisent". [16].

Sophia Oakes, spécialiste de l'art, raconte dans sa publication qu'elle a demandé à ChatGPT si l'intelligence artificielle remplacerait les artistes et les gens de l'art. Sa réponse a été la suivante : "L'intelligence artificielle a la capacité de créer des œuvres d'art, et il existe déjà des peintures, de la musique et de la littérature créées par l'IA qui peuvent être difficiles à distinguer de celles créées par les humains. Cependant, il est important de noter que ces œuvres d'art créées par l'intelligence artificielle sont toujours créées avec la participation et l'orientation de l'homme. Si l'intelligence artificielle peut générer des idées nouvelles et uniques, elle n'a pas la capacité de comprendre les émotions, les expériences et le contexte culturel de l'homme de la même manière que lui. Il s'agit là d'aspects cruciaux de l'art, qui lui donnent un sens et trouvent un écho auprès du public. Il est donc peu probable que l'intelligence artificielle remplace complètement l'art et les artistes. Au contraire, l'intelligence artificielle peut être utilisée comme un outil pour assister le processus créatif ou générer de nouvelles idées, mais le produit final nécessitera toujours la perspective, l'interprétation et l'expression uniques d'un artiste humain" [17].

Il s'agit de la réponse générée par le robot sur la base des données qui lui ont été intégrées par les programmeurs. Sophia résume que la créativité est une partie nécessaire de l'expérience humaine : un moyen de réflexion, une archive de la vie et, dans les cas les plus inspirés, un reflet du divin. Et sans l'expérience humaine, l'IA elle-même ne peut pas fonctionner.

Dans Neuromancien, Gibson le souligne à deux reprises. Le premier est un mot, un mot de passe, qui doit être prononcé à un certain moment par le système pour qu'il s'ouvre. Il s'agit certainement d'une référence au Nouveau Testament et à l'idée du Logos, qu'une IA ne peut pas avoir. La seconde est celle des émotions, que l'IA ne possède pas non plus. Il est possible de les simuler, mais il ne s'agira pas de véritables expériences inhérentes à l'être humain. Pour surmonter le dernier obstacle dans le cyberespace, le hacker du roman avait besoin de colère - sans elle, il ne pouvait pas mener à bien sa mission.

Comme beaucoup d'auteurs de science-fiction, Gibson était un prophète de son époque. Mais il y a beaucoup de notes sombres dans ses prophéties. On retrouve probablement la même intuition chez Ilon Musk, qui, bien qu'il ait lui-même investi dans l'IA, affirme que l'IA pourrait détruire la civilisation [18].

Références :

[1] - balkaninsight.com

[2] - wired.com

[3] - wsj.com

[4] - japannews.yomiuri.co.jp

[5] - https://ipis.ir/en/subjectview/722508

[6] - ft.com

[7] - weforum.org

[8] - energy.gov

[9], [15] - theguardian.com

[10] - project-syndicate.org

[11] - wired.co.uk

[12] - ft.com

[13] - wired.co.uk

[14] - project-syndicate.org

[16] - theamericanconservative.com

[17] - countere.com

[18] - cnn.com

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.  La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149).

La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149). Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent.

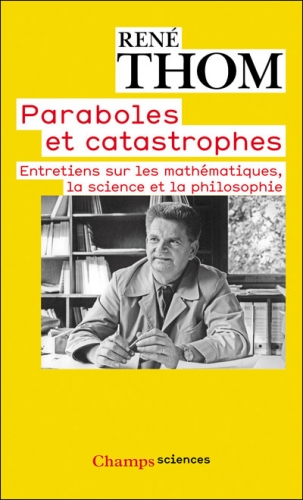

Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent. Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

del.icio.us

del.icio.us

Digg

Digg

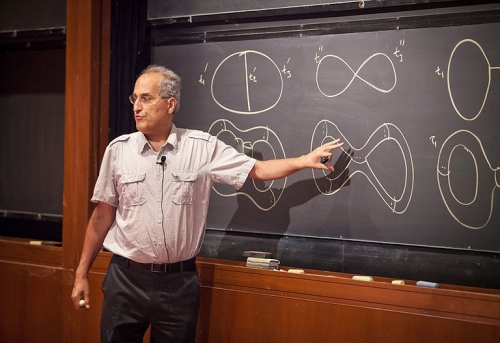

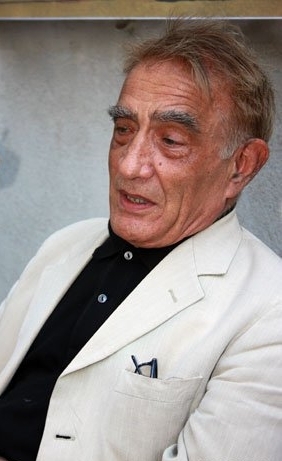

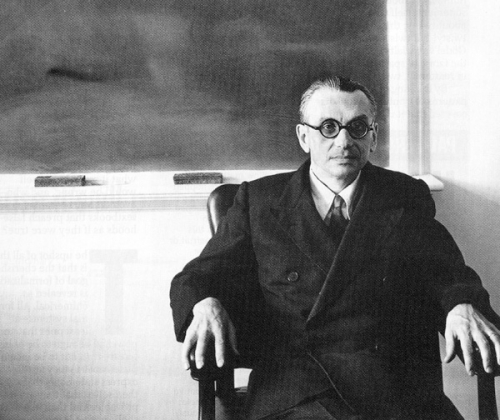

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

En effet, cette étude démontre qu'une région cérébrale et des neurones, impliqués dans un sens précis peuvent aussi interpréter d'autres types d'informations sensorielles. « Les nerfs ont répondu en même temps au toucher et à la lumière infrarouge. Ceci montre que le cerveau humain peut acquérir de nouvelles capacités qui n'ont jamais été expérimentées sur l'animal avant cela », a ajouté le scientifique. En théorie, une personne aveugle pour cause de dommage au niveau du cortex visuel pourrait recouvrer la vue en utilisant un implant sur une autre partie de son cerveau. Tout comme pourrait le faire une personne devenue sourde en raison de dommages au niveau du cortex auditif. « Ceci suggère que, dans le futur, il serait possible d'utiliser des dispositifs de type prothèses pour restaurer des modalités sensorielles qui ont été perdues, telles que la vision, en utilisant une partie cérébrale différente », a confirmé le

En effet, cette étude démontre qu'une région cérébrale et des neurones, impliqués dans un sens précis peuvent aussi interpréter d'autres types d'informations sensorielles. « Les nerfs ont répondu en même temps au toucher et à la lumière infrarouge. Ceci montre que le cerveau humain peut acquérir de nouvelles capacités qui n'ont jamais été expérimentées sur l'animal avant cela », a ajouté le scientifique. En théorie, une personne aveugle pour cause de dommage au niveau du cortex visuel pourrait recouvrer la vue en utilisant un implant sur une autre partie de son cerveau. Tout comme pourrait le faire une personne devenue sourde en raison de dommages au niveau du cortex auditif. « Ceci suggère que, dans le futur, il serait possible d'utiliser des dispositifs de type prothèses pour restaurer des modalités sensorielles qui ont été perdues, telles que la vision, en utilisant une partie cérébrale différente », a confirmé le .jpg)

Unfraglich bietet die Antarktis unzählige Möglichkeiten für zivile Forschungsprojekte. Was da geschieht, dient friedlichen Zwecken, sei es die Ergründung des Klimas oder der Geologie, seien es Aspekte medizinischer Natur, wenn Menschen unter extremer Abgeschiedenheit leben müssen – wichtig auch für eine spätere Besiedlung fremder Himmelskörper –, seien es grundsätzliche astronomische Beobachtungen unter beinahe idealen Bedingungen und die Suche nach seltenen Steinen aus dem All, seien es auch jene biologischen Forschungen zu teilweise seit Jahrmillionen abgeschlossenen Lebensräumen. Doch vielfach findet sich eben auch die Nähe zu einer militärischen Anwendung.

Unfraglich bietet die Antarktis unzählige Möglichkeiten für zivile Forschungsprojekte. Was da geschieht, dient friedlichen Zwecken, sei es die Ergründung des Klimas oder der Geologie, seien es Aspekte medizinischer Natur, wenn Menschen unter extremer Abgeschiedenheit leben müssen – wichtig auch für eine spätere Besiedlung fremder Himmelskörper –, seien es grundsätzliche astronomische Beobachtungen unter beinahe idealen Bedingungen und die Suche nach seltenen Steinen aus dem All, seien es auch jene biologischen Forschungen zu teilweise seit Jahrmillionen abgeschlossenen Lebensräumen. Doch vielfach findet sich eben auch die Nähe zu einer militärischen Anwendung.