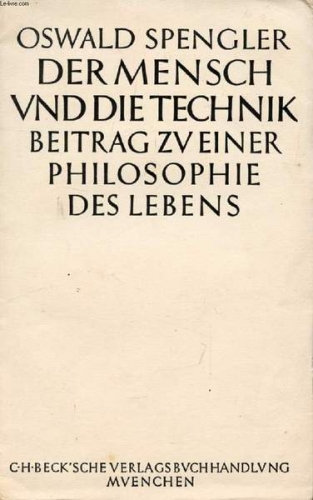

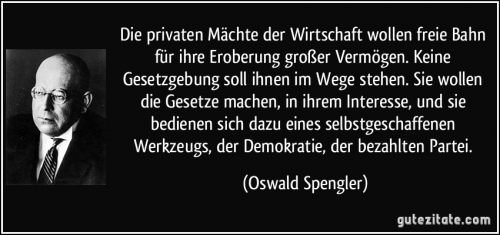

Oswald Spengler’s writings on the subject of the philosophy of science are very controversial, not only among his detractors but even for his admirers. What is little understood is that his views on these matters did not exist in a vacuum. Rather, Spengler’s arguments on the sciences articulate a long German tradition of rejecting English science, a tradition that originated in the eighteenth century.

Luke Hodgkin notes:

It is today regarded as a matter of historical fact that Isaac Newton and Gottfried Wilhelm Leibniz both independently conceived and developed the system of mathematical algorithms known collectively by the name of calculus. But this has not always been the prevalent point of view. During the eighteenth century, and much of the nineteenth, Leibniz was viewed by British mathematicians as a devious plagiarist who had not just stolen crucial ideas from Newton, but had also tried to claim the credit for the invention of the subject itself.[1] [2]

This wrongheaded view stems from Newton’s own catty libel of Leibniz on these matters. During this time, the beginning of the eighteenth century, Leibniz’s native Prussia had not yet become a serious power through the wars of Frederick the Great. Leibniz, together with Frederick the Great’s grandfather, founded the Royal Prussian Academy of Sciences. Newton’s slanderous account of Leibniz’s achievements would never be forgiven by the Germans, to whom Newton remained a bête noire as long as Germany remained a proud nation.

In the context of inquiring into the matter of how such a pessimist as Spengler could admire so notorious an optimist as Leibniz, two foreign members of the Prussian Academy of Sciences merit attention. The thought of French scientist and philosopher Pierre Louis Moreau de Maupertuis, an exponent and defender of Leibnizian ideas, was in many ways a precursor to modern biology. Maupertuis wrote under the patronage of Frederick the Great, about a generation after Leibniz. Compared to other eighteenth-century philosophies, Maupertuis’ worldview, like modern biology and unlike most Enlightenment thought, presents nature as rather “red in tooth and claw.”

An earlier foreign member of the Prussian Academy of Sciences, a contemporary and correspondent of Leibniz, Moldavian Prince (and eccentric pretender to descent from Tamerlane) Dimitrie Cantemir, left two cultural legacies to Western history. Initially an Ottoman vassal, he gave traditional Turkish music its first system of notation, ushering in the classical era of Turkish music that would later influence Mozart. Later – after he had turned against the Ottoman Porte in an alliance with Petrine Russia, but was driven out of power and into exile due to his abysmal battlefield leadership – he wrote much about history. Most impactful in the West was a two-volume book that would be translated into English in 1734 as The History of the Growth and Decay of the Othman Empire. Voltaire and Gibbon later read Cantemir’s work, as did Victor Hugo.[2] [3]

Notes one biographer, “Cantemir’s philosophy of history is empiric and mechanistic. The destiny in history of empires is viewed . . . through cycles similar to the natural stages of birth, growth, decline, and death.”[3] [4] Long before Nietzsche popularized the argument, Cantemir proposed that high cultures are initially founded by barbarians, and also that a civilization’s level of high culture has nothing to do with its political success.[4] [5] Thus was the Leibnizian intellectual legacy mixed with pessimism even in Leibniz’s own lifetime.

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

By the early modern age of European history, when Goethe’s Faust takes place, cabalistic doctrines, notes Carl Schmitt, “became known outside Jewry, as can be gathered from Luther’s Table Talks, Bodin’s Demonomanie, Reland’s Analects, and Eisenmenger’s Entdecktes Judenthum.”[5] [6] This phenomenon can be traced to the indispensable influence of the very inventors of cabalism, collectively speaking, on the West’s transition from feudalism to modern capitalism since the Age of Discovery, and in some cases even earlier. In 1911’s The Jews and Modern Capitalism, Werner Sombart points out that “Venice was a city of Jews” as early as 1152.

Cabalism deeply permeates the worldviews of many influential secret societies of Western history since medieval times, and certainly continuing with the official establishment of Freemasonry in 1717. Although the details will never be entirely clear, it is known that Goethe was involved with the Bavarian Illuminati in his youth. He seems to have experienced conservative disillusionment with it later in life. It is possible that the posthumous publication of Faust: The Second Part of the Tragedy was due at least in part to the book’s ambivalently revealing too much about the esoterica of Goethe’s former occult activities.

What is clear is that he was directly interested in cabalistic concepts. Karin Schutjer persuasively argues that “Goethe had ample opportunity to learn about Jewish Kabbalah – particularly that of the sixteenth-century rabbi Isaac Luria – and good reason to take it seriously . . . Goethe’s interest in Kabbalah might have been further sparked by a prominent argument concerning its philosophical reception: the claim that Kabbalistic ideas underlie Spinoza’s philosophy.”[6] [7]

At one point in the second part of Faust, Goethe shows an interest in monetary issues related to usury or empty currency, as Schopenhauer after him would.[7] [8] This is fitting for a story that takes place in early modern Europe and concerns an alchemist. Some early modern alchemists were known as counterfeiters and would have most likely had contact with Jewish moneylenders. Insofar as his scientific philosophy had a social, and not just an intellectual, significance, this desire on Goethe’s part for economic concreteness was perhaps what led him to reject and combat one key cabalistic doctrine: numerology.

Numerology is the belief that numbers are divine and have prophetic power over the physical world. Goethe held the virtually opposite view of numbers and mathematical systems, proposing that “strict separation must be maintained between the physical sciences and mathematics.” According to Goethe, it is an “important task” to “banish mathematical-philosophical theories from those areas of physical science where they impede rather than advance knowledge,” and to discard the “false notion that a phrase of a mathematical formula can ever take the place of, or set aside, a phenomenon.” To Goethe, mathematics “runs into constant danger when it gets into the terrain of sense-experience.”[8] [9]

In his well-researched 1927 book on Freemasonry, General Erich Ludendorff remarks, “One must study the cabala in order to understand and evaluate the superstitious Jew correctly. He then is no longer a threatening opponent.”[9] [10] In his proceeding discussion of the subject, Ludendorff focuses exclusively on the numerological superstitions in cabalism. Such beliefs are affirmed by a Jewish cabalistic source, which informs us that “Sefirot” is the Hebrew word for numbers, which represent “a Tree of Divine Lights.”[10] [11]

Everything about Goethe’s rejection of scientific materialism can be seen as a rebellion against numerology in the sciences – and certainly, the modern mathematical sciences stand on the shoulders of numerology, as modern chemistry does on alchemy. Schmitt once mentioned the “mysterious Rosicrucian sensibility of Descartes,” a reference to the mysterious cabalistic initiatory movement that dominated the scientific philosophies of the seventeenth century.[11] [12] In this Descartes was hardly alone; the entire epoch of mostly French and English mathematicians in the early modern centuries, which ushered in the modern infinitesimal mathematical systems, was infused with cabalism. Even if it were possible to ignore the growing Jewish intellectual and economic influence on that age, one would still be left with the metaphysical affinities between numerology and even the most scientifically accomplished worldview that takes literally the assumption that numbers are eternal principles.

According to early National Socialist economist Gottfried Feder, “When the Babylonians overcame the Assyrians, the Romans the Carthaginians, the Germans the Romans, there was no continuance of interest slavery; there were no international world powers . . . Only the modern age with its continuity of possession and its international law allowed loan capitals to rise immeasurably.”[12] [13] Writing in 1919, Feder argues with the help of a graph that that “loan-interest capital . . . rises far above human conception and strives for infinity . . . The curve of industrial capital on the other hand remains within the finite!”[13] [14] Goethe may have similarly drawn connections between the kind of economic parasitism satirized in the second part of Faust and what he, like Berkeley, saw as the superstitious modern art of measuring the immeasurable.

The fusion of science with numerology, it should be noted, is actually not of Hebrew or otherwise pre-Indo-European origin. It originates from pre-Socratic Greek philosophy’s debt, particularly that of the Pythagoreans, to the Indo-Iranian world, chiefly Thrace.[14] [15] (Possibly of note in this regard is that Schopenhauer admired the Thracians for their arch-pessimistic ethos, as though this mindset were the polar opposite of the world-affirming Jewish worldview he loathed.)[15] [16] In any case, Goethe recognized it as a powerful weapon. That he studied numerology has been established by scholars.[16] [17]

A generation before Goethe, Immanuel Kant had propounded the idea that the laws of polarity – the laws of attraction and repulsion – precede the Newtonian laws of matter and motion in every way. This argument would influence Goethe’s friend Friedrich Wilhelm von Schelling, another innovator in the life sciences as well as part of the literary and philosophical movement known as Romanticism. By the time Goethe propounded his anti-Newtonian theories and led a philosophical milieu, he had an entire German tradition of such theories to work from.

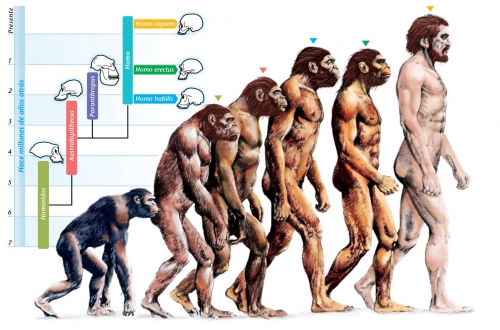

Goethe’s work was influential in Victorian Britain. Most notably, at least in terms of the scientific history of that era, Darwin would cite Goethe as a botanist in On the Origin of the Species. Darwin’s philosophy of science, to the extent that he had one, was largely built on that of Goethe and the age of what came to be known as Naturphilosophie. Historian of science Robert J. Richards has found that “Darwin was indebted to the Romantics in general and Goethe in particular.”[17] [18] Darwin had been introduced to the German accomplishments in biology, and the German ideas about philosophy of science, mainly through the work of Alexander von Humboldt.[18] [19]

Why has this influence been forgotten? “In the decade after 1918,” explains Nicholas Boyle, “when hundreds of British families of German origin were forcibly repatriated, and those who remained anglicized their names, British intellectual life was ethnically cleansed and the debt of Victorian culture to Germany was erased from memory, or ridiculed.”[19] [20] To some extent, this process had already started since the outbreak of the First World War.

This intellectual ethnic cleansing would not go unreciprocated. In 1915’s Händler und Helden (Merchants and Heroes), German economist and sociologist Werner Sombart attacked the “mercantile” English scientific tradition. Here, Sombart is particularly critical of what he calls the “department-store ethics” of Herbert Spencer, but in general Sombart calls for most English ideas – including English science – to be purged from German national life. In his writings on the philosophy of science, Spengler would answer this call.

Spengler heavily drew on the ideas of Goethe, and evidently also on the views of a pre-Darwinian French Lutheran paleontologist of German origin, Georges Cuvier. For instance, Spengler’s assault on universalism in the physical sciences mostly comes from Goethe, but his rationale for rejecting Darwinian evolution appears to come from Cuvier. The idea that life-forms are immutable, and simply die out, only to be superseded by unrelated new ones – a persistent theme in Spengler – comes more from Cuvier than Goethe.

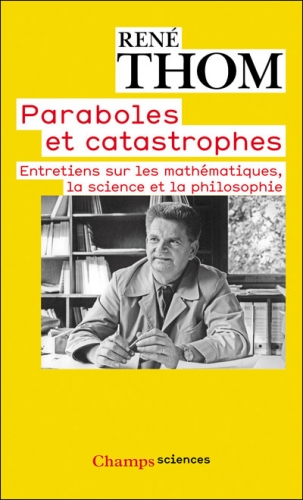

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.[20] [21]

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.[20] [21]

Several asides about Cuvier are in order. First of all, this criminally underrated thinker is by no means outmoded, at least not in every way. Modern geology operates on a more-Cuvieran-than-Darwinian plane.[21] [22] Secondly, it is worth noting that Ernst Jünger once astutely observed that Cuvier is more useful to modern military science than Darwin.[22] [23] It may also be of interest that the Cuvieran system is even further removed from Lamarckism – and its view of heredity, as a consequence, more thoroughly racialist – than the Darwinian system.[23] [24]

Another scientist of German origin who may have influenced Spengler is the Catholic monk Gregor Mendel, the discoverer of what is now known as genetics. One biography notes:

Though Mendel agreed with Darwin in many respects, he disagreed about the underlying rationale of evolution. Darwin, like most of his contemporaries, saw evolution as a linear process, one that always led to some sort of better product. He did not define “better” in a religious way – to him, a more evolved animal was no closer to God than a less evolved one, an ape no morally better than a squirrel – but in an adaptive way. The ladder that evolving creatures climbed led to greater adaption to the changing world. If Mendel believed in evolution – and whether he did remains a matter of much debate – it was an evolution that occurred within a finite system. The very observation that a particular character trait could be expressed in two opposing ways – round pea versus angular, tall plant versus dwarf – implied limits. Darwin’s evolution was entirely open-ended; Mendel’s, as any good gardener of the time could see, was closed.[24] [25]

How very Goethean – and Spenglerian.

His continuation of the German mission against English science explains, even if it does not entirely excuse, Spengler’s citation of Franz Boas’ now-discredited experiments in craniology in the second volume of The Decline of the West. In his posthumously-published book on Indo-Europeanology, the unfinished but lucid Frühzeit der Weltgeschichte, Spengler cites the contemporary German Nordicist race theorist Hans F. K. Günther in writing that “urbanization is racial decay.”[25] [26] This would seem quite a leap, from citing Boas to citing Günther. However, in the opinion of one historian, Boas and Günther had more in common than they liked to think, because they were both heirs more of the German Idealist tradition in science than what the Anglo-Saxon tradition recognizes as the scientific method.[26] [27] Spengler must have keenly detected this commonality, for his views on racial matters were never synonymous with those of Boas, any more than they were identical to Günther’s.

He probably went too far in his crusade against the Anglo-Saxon scientific tradition, but as we have seen, Spengler was not without his reasons. He was neither the first nor the greatest German philosopher of science to present alternatives to the ruling English paradigms in the sciences, but was rather an heir to a grand tradition. Before dismissing this anti-materialistic tradition as worthless, as today’s historiographers of science still do, we should take into account what it produced.

Darwin’s philosophy of nature was predominantly German; only his Malthusianism, the least interesting aspect of Darwin’s work, was singularly British. As for Einstein, that proficient but unoriginal thinker was absolutely steeped in the German anti-Newtonian tradition, to which he merely put a mathematical formula. These are only the most celebrated examples of scientists influenced by the German tradition defended – maniacally, perhaps, but with noble intentions – in the works of Oswald Spengler.

Whether we consider Spengler’s ideas useful to science or utterly hateful to it, one question remains: Should the German tradition of philosophy of science he defended be taken seriously? Ever since the post-Second World War de-Germanization of Germany, euphemistically called “de-Nazification,” this tradition is now pretty much dead in its own fatherland. But does that make it entirely wrong?

Notes

[1] [28] Luke Hodgkin, A History of Mathematics: From Mesopotamia to Modernity (Oxford: Oxford University Press, 2013).

[2] [29] See the booklet of the CD Istanbul: Dimitrie Cantemir, 1630-1732, written by Stefan Lemny and translated by Jacqueline Minett.

[3] [30] Eugenia Popescu-Judetz, Prince Dimitrie Cantemir: Theorist and Composer of Turkish Music (Istanbul: Pan Yayıncılık, 1999), p. 34.

[4] [31] Dimitrie Cantemir, The History of the Growth and Decay of the Othman Empire, vol. I, tr. by Nicholas Tindal (London: Knapton, 1734), p. 151, note 14.

[5] [32] Carl Schmitt, The Leviathan in the State Theory of Thomas Hobbes: Meaning and Failure of a Political Symbol, tr. by George Schwab and Erna Hilfstein (Chicago: University of Chicago Press, 2008), p. 8.

[6] [33] Karin Schutjer, “Goethe’s Kabbalistic Cosmology [34],” Colloquia Germanica, vol. 39, no. 1 (2006).

[7] [35] J. W. von Goethe, Faust, Part Two, Act I, “Imperial Palace” scene; Schopenhauer, The Wisdom of Life, Chapter III, “Property, or What a Man Has.”

[8] [36] Jeremy Naydler (ed.), Goethe on Science: An Anthology of Goethe’s Scientific Writings (Edinburgh: Floris Books, 1996), pp. 65-67.

[9] [37] Erich Ludendorff, The Destruction of Freemasonry Through Revelation of Their Secrets (Mountain City, Tn.: Sacred Truth Publishing), p. 53.

[10] [38] Warren Kenton, Kabbalah: The Divine Plan (New York: HarperCollins, 1996), p. 25.

[11] [39] Schmitt, Leviathan, p. 26.

[12] [40] Gottfried Feder, Manifesto for Breaking the Financial Slavery to Interest, tr. by Alexander Jacob (London: Black House Publishing, 2016), p. 38.

[13] [41] Ibid., pp. 17-18.

[14] [42] See, i.e., Walter Wili, “The Orphic Mysteries and the Greek Spirit,” collected in Joseph Campbell (ed.), The Mysteries: Papers from the Eranos Yearbooks (Princeton, N.J.: Princeton University Press, 1955).

[15] [43] Arthur Schopenhauer, tr. by E. F. J. Payne, The World as Will and Representation, vol. II (Mineola, N.Y.: Dover, 2014), p. 585.

[16] [44] Ronald Douglas Gray, Goethe the Alchemist (Cambridge: Cambridge University Press, 2010), p. 6.

[17] [45] Robert J. Richards, The Romantic Conception of Life: Philosophy and Science in the Age of Goethe (Chicago: The University of Chicago Press, 2010), p. 435.

[18] [46] Ibid, pp. 518-526.

[19] [47] Nicholas Boyle, Goethe and the English-speaking World: Essays from the Cambridge Symposium for His 250th Anniversary (Rochester, N.Y.: Camden House, 2012), p. 12.

[20] [48] Oswald Spengler, tr. by Charles Francis Atkinson, The Decline of the West vol. II (New York: Alfred A. Knopf, 1928), p. 31.

[21] [49] Elizabeth Kolbert, The Sixth Extinction: An Unnatural History (London: Bloomsbury, 2015), p. 94.

[22] [50] From Jünger’s Aladdin’s Problem: “It is astounding to see how inventiveness grows in nature when existence is at stake. This applies to both defense and pursuit. For every missile, an anti-missile is devised. At times, it all looks like sheer braggadocio. This could lead to a stalemate or else to the moment when the opponent says, ‘I give up’, if he does not knock over the chessboard and ruin the game. Darwin did not go that far; in this context, one is better off with Cuvier’s theory of catastrophes.”

[23] [51] See Georges Cuvier, Essay on the Theory of the Earth (London: Forgotten Books, 2012), pp. 125-128 & pp. 145-165.

[24] [52] Robin Marantz Henig, The Monk in the Garden: The Lost and Found Genius of Gregor Mendel, the Father of Genetics (New York: Houghton Mifflin, 2017), p. 125.

[25] [53] Oswald Spengler, Frühzeit der Weltgeschichte (Munich: C. H. Beck, 1966), Fragment 101.

[26] [54] Amos Morris-Reich, “Race, Ideas, and Ideals: A Comparison of Franz Boas and Hans F. K. Günther [55],” History of European Ideas, vol. 32, no. 3 (2006).

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.  La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149).

La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149). Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent.

Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent. Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

del.icio.us

del.icio.us

Digg

Digg

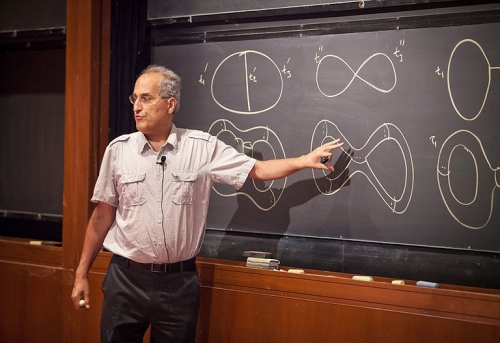

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

Elon Musk

Elon Musk

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.

Apollinische antieke wiskunde

Apollinische antieke wiskunde