Thomas C. Leonard

Illiberal Reformers: Race, Eugenics & American Economics in the Progressive Era [2]

Princeton: Princeton University Press, 2016

In many ways the Progressive Era embodies the best of white America. It was a period of compassion, community concern, attempts to raise the living standard of average Americans, a desire to achieve class harmony, to end (or at least reduce) capitalist corruption, and to create a workable, harmonious racial nationalism that would ensure the long-term fitness of American society. The concerns of the Progressives were as much for the future as they were for the present, something almost wholly lacking in contemporary American politics. These scholars, politicians, and activists thought deeply about future generations and recognized, almost to a man, the validity of race science and the crucial role race plays in the historical trajectory of any country.

In many ways the Progressive Era embodies the best of white America. It was a period of compassion, community concern, attempts to raise the living standard of average Americans, a desire to achieve class harmony, to end (or at least reduce) capitalist corruption, and to create a workable, harmonious racial nationalism that would ensure the long-term fitness of American society. The concerns of the Progressives were as much for the future as they were for the present, something almost wholly lacking in contemporary American politics. These scholars, politicians, and activists thought deeply about future generations and recognized, almost to a man, the validity of race science and the crucial role race plays in the historical trajectory of any country.

Thomas Leonard, a research scholar and lecturer in economics at Princeton University, has written an interesting history of the interaction between race, eugenics, and economics in the context of the Progressive movement. It is broadly informative and happily lacking the willful opacity of much contemporary scholastic writing, thus making it accessible to a wide audience. Unfortunately, yet unsurprisingly, this book begins with a blatant lie upon which he constructs his narrative: “Eugenics and race science are today discredited” (p. xiv). As such, the book is fundamentally flawed. Dr. Leonard offers no evidence whatsoever as to why Progressive notions of racial health and eugenics were wrong but, in keeping with contemporary academic fashion, merely resorts to shaming words and moral judgments rather than even a cursory investigation into the validity of the claims.

The book provides a detailed history of the many important Progressive intellectuals who believed that race was a fundamental concern and how they thought it should be dealt with politically, socially, and economically. The Progressives are perhaps the best example of a genuine American attempt to transcend the awkward political dichotomy of Left and Right for the sake of the greater good and a vision of a better and healthier future. Progressive diagnoses and predictions of racial degeneration and a dystopian future were so accurate that one suspects this book, to the extent it is read by objective and open-minded readers, will emphasize rather than deemphasize the importance of these issues.

The first chapter, entitled “Redeeming American Economic Life,” the author sets the context for the development of Progressivism by describing their reaction to the cycle of boom and bust of the dramatically expanding postbellum American economy: the rapid industrialization and urbanization of American society; and the tensions between labor, farmers, and capitalists. Despite the range of attitudes within the Progressive movement towards possible solutions to the problems faced at this time, Progressives shared three things in common: first, discontent with liberal individualism; second, “discontent with the waste, disorder, conflict, and injustice they ascribed to industrial capitalism”; and third, a concern with the problems of monopoly (pp. 8-9). Their understanding of these issues drove them to believe in the necessity of an administrative state to remedy these root problems and their many offshoots. As Dr. Leonard writes, the “progressives had different and sometimes conflicting agendas” but “nearly all ultimately agreed that the best means to their several ends was the administrative state” (p. 9). Those intellectuals who would become Progressives began to turn their focus away from the traditional and reflective scholarly disciplines and towards active ones, i.e. economics, politics, sociology, and public administration (p. 11). This activist turn was integral to the movement.

The author traces some of this activist drive for public improvement to the “social gospel” wing of Protestantism, but as knowledge of science and the use of scientific language increasingly became a marker of intellectual sophistication, the two were eventually combined into a mutually-reinforcing reformist spirit. Following World War I, after which the West experienced something of an existential crisis, the specifically Christian reform rhetoric mostly faded, or, as the author terms it, was “socialized” (p. 13), and mostly replaced by the hard empirical language of the above-mentioned burgeoning “active” disciplines. However, the sense of missionary zeal and notions of secular “salvation” remained a hallmark of the Progressive movement. If salvation could be socialized so too could sin (p. 13). That is to say, those problems that had previously been seen at least partially as religious in nature became social. Laissez-faire capitalism, for example, was not rapacious and exploitative merely because it was a sinful system run by sinful people but because it was “scientifically” incorrect. The Bible could offer insights into social problems but ultimately the responsibility fell to the state to re-make society in accordance with Christian ethics.

In the second chapter, “Turning Illiberal,” Dr. Leonard describes the professionalization of economics, the turn away from British classical liberalism towards German economic theory, and the origins of tensions within the Progressive movement between those who believed in democracy and those who did not. Germany, by the late 19th century had become the premier destination for graduate students wishing to study political economy. Germans were on the cutting edge of this newly formalized discipline — one that was almost entirely nonexistent in American universities. In contrast to Anglo-American classical liberalism, Germans saw the economy as a “product of a nation’s unique development” and believed that its “workings were not unalterable natural laws, [but] were historically contingent and subject to change” (p. 17). The author writes:

The progressives’ German professors had taught them that economic life was historically contingent. The economy wrought by industrial capitalism was a new economy, and a new economy necessitated a new relationship between the state and economic life. Industrial capitalism, the progressives argued, required continuous supervision, investigation, and regulation. The new guarantor of American progress was to be the visible hand of an administrative state, and the duties of administration would regularly require overriding individuals’ rights in the name of the common good (pp. 21-22).

Germans had demonstrated to American students that economics could be a tool of statist reform with a sound theoretical basis. They also demonstrated that it could be a distinguished and respected career path (p. 18). Those students who returned from Germany came home with a very different conception of the role of the economy in relation to the state and, at the same time, had little competition in establishing themselves in American universities and think tanks. It was a powerful position from which to begin their activism, both in terms of knowledge and opportunity.

Just as the German view of the relationship between state and economy had informed American Progressives, so too did the German Historical School’s conception of the nation as an organism (p. 22). This, coupled with the tremendous influence of Darwinist evolutionary theory in all intellectual circles, caused a distinct shift away from American individualism. Richard Ely, founder of the American Economic Association and a highly influential Progressive, explicitly rebuked the notion that the individual comes before society. Washington Gladden, a charter member of the same organization, argued that American individualism was “a radical defect in the thinking of the average American” (p. 22). The concept of the autonomous individual was seen by Progressive economists as a relic of a soundly refuted, old-fashioned ideology. A new class of superior, scientifically-informed men had to take charge of society if it were to rid itself of such antiquated and backwards beliefs.

In the third chapter, “Becoming Experts,” the author delves deeper into the tensions between expertise and democracy, the differences between Left and Right Progressives, the building of the administrative state, and “war collectivism.” Progressives maintained that the good of the people could best be guaranteed by limiting the power of the people — or, expressed positively, by entrusting the care of the people to experts. Dr. Leonard writes: “Financial crisis, economic panic, violent labor conflict, a political war over monetary policy, and the takeoff of the industrial merger movement combined to generate a groundswell of support for economic reform” (p. 30). This convinced many important Progressive intellectuals that government service was a far more important use of their expertise than was the role of public intellectual. Activism was a crucial strategic and ideological element of their project. The future, according to Progressives, should not be left to chance. It had to be engineered, and someone had to engineer it. If one genuinely cared for future generations, a processes to guarantee their success had to be put in motion rather than simply theorized.

In his discussion of the distinction between Left and Right, Dr. Leonard accurately dismantles the problems with this dichotomous analytical tool. He writes that “progressive” is a “political term and political historians tend to an ideological lens . . . Ideology is [a] useful tool of taxonomy, but when it is reduced to one dimension, it is the enemy of nuance” (p. 38). Rather than frame Progressives as either Left or Right, he usually prefers the term “illiberal” — the belief that, contra liberalism, society takes preference over the individual. Indeed, the very concept of “reform” is often tainted with a Leftism that isn’t always quite there. Many of the positions that modern progressives hold today would be abhorrent to historical Progressives, just as many positions that conservatives hold today would be abhorrent to conservatives of the era. For example, the Progressive Republican Theodore Roosevelt was no fan of laissez-faire capitalism and favored an increase in the regulatory powers of the government, while William Graham Sumner, a conservative opponent of Progressivism, was a believer in free markets but a staunch opponent of imperialism and big business (pp. 39-40). The political battle lines of today differ greatly from those of the past, a fact which seems to validate the 19th century Germanic conception of the relationship of state, economy, and law as being historically contingent. What we think of now as Left or Right was largely absent from Progressive discourse.

Dr. Leonard goes on to discuss the creation of what he calls the “fourth branch” of government (the administrative agencies). The quintessential example of the ascendancy of the fourth branch is the Wisconsin Idea — the integration of government and academic experts in Wisconsin in order to govern the state with maximum efficiency. Many involved in the creation of this integrated system credited its success specifically with the heavy German population of the state. In his 1912 book on the subject, Charles McCarthy described the architect of the Wisconsin Idea, Robert Ely, “as a pupil of German professors, who returned from Germany with German political ideals to teach German-inspired economics at a German university (the University of Wisconsin) in the German state of Wisconsin, where the young men he most inspired were, yes, of German stock” (p. 41). The state government was, to a previously unknown degree, put in the charge of Progressive experts who created on American soil what was in effect an ethnic German state. The Progressive movement, both in theory and in practice, was distinctly Teutonic in conception.

This “fourth branch” of government was established in Washington D.C. by Woodrow Wilson and solidified during World War I by the success of “war collectivism.” The hand of the federal government was greatly strengthened at this time in order to aid the war effort. This is the period in which the income tax was established and was soon followed by corporate and inheritance taxes as well as numerous other reforms and the creation of various administrative agencies (pp. 43-45). Having established themselves as experts, the expert recommendations of the Progressives usually included the establishment of permanent regulatory agencies — “ideally an independent agency staffed by economic experts with broad discretionary powers to investigate and regulate” (p. 43). The author credits much of this to personal ambition rather than idealism, which is doubtless true to some extent but is at odds with his earlier descriptions of the visionary reformist mission of Progressives. Perhaps writing a century later it is hard not to be cynical about such things, but little in his prior discussion would indicate personal ambition as a primary motivating force. And even if it had been the case, their efforts were consistent with their ideology. Personal ambition without value-compromise can hardly be seen as a negative. But throughout the book attempts to tarnish the images of Progressives by insinuating that they were somehow morally compromised (how else to explain their illiberal views?).

Toward the end of the chapter, the author begins his discussion of race, a central concern of Progressives. It was simply understood by Progressives (and most others of the time) that blacks were incapable of freedom. Woodrow Wilson wrote that blacks were “unpracticed in liberty, unschooled in self-control, never sobered by the discipline of self-support, never established in any habit of prudence . . . insolent and aggressive, sick of work, [and] covetous of pleasure” (p. 50). The sociologist Edward Ross, in a statement the author refers to as demonstrating contempt for his “imagined inferiors” (p. 50) wrote: “One man, one vote . . . does not make Sambo equal to Socrates” (p. 50). Such statements seem to contradict the Progressive belief in the elevation of the common man (as contemporarily understood) but as Dr. Leonard points out, the “progressive goal was to improve the electorate, not necessarily expand it” (p. 50). The whole of the country would be better off if its leadership could be entrusted to a superior piece of the American electorate. This was a fundamental tension among Progressives: “Democracies need to be democratic, but they also need to function . . .” (p. 51). American democracy could not function with unintelligent people voting but, given American history, the concept of voting was not up for debate. Thus began the deliberate disenfranchisement of blacks and others deemed unfit for equal rights in American society.

In chapter four, “Efficiency in Business and Public Administration,” the author details the Progressive push for efficiency, the influence of Taylorism, and the beginning of the scientific measurement of mankind for utilitarian purposes. Objective as possible in their approach to the economy, Progressives (with few exceptions) did not regard big business itself as a problem. Scale was, for them, unrelated to efficiency. Efficiency was a goal that could be handled by experts regardless of the size of the project. The classical liberal notion of market efficiency, even if it could be demonstrated to be true, was, like Darwinian evolution, a slow and haphazard process that could be sped up and forced in entirely desirable directions with proper management. Big business was simply a fact of the new economy. As such, it was not undesirable in and of itself, but required outside guidance to achieve socially acceptable results while avoiding “market-made waste” (p. 57). Progressives famously feared monopoly because it could produce political corruption as well as reduce innovation but, as the author writes, “progressives distinguished monopoly from size, and because of this, were not antimonopoly in the populist sense of the term” (p. 57). Indeed, big business was generally thought to be inherently more efficient than small business. As with everything else, proper administration was the key to success.

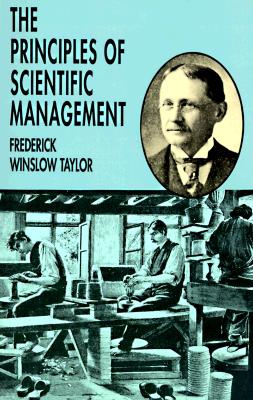

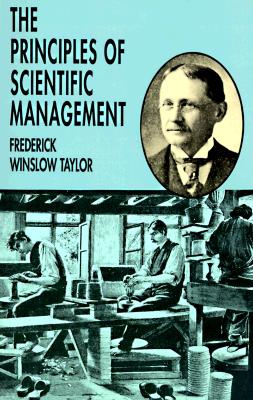

The 1911 publication of Frederick Taylor’s The Principles of Scientific Management was a watershed moment for Progressives. It offered a scientific method for improving workplace efficiency. By measuring and analyzing everything from workplace break times to the weight of shoveled material, industry would be able to maximize efficiency down to the minute and the pound. Taylorism has since become an epithet, used to describe the dehumanizing effects of the time clock, the oppressive nature of constant managerial supervision, and the turn away from skilled labor in the workforce. However, for Progressives it promised a new approach to the workplace that could make life better for everyone. Those experts who would take charge of industry would be able to maximize the public good while minimizing the power of capitalists and financiers. Men such as the Progressive political philosopher Herbert Croly believed that Taylorism would “[put] the collective power of the group at the hands of its ablest members” (p. 62). For Progressives, scientific management was a noble goal and a model to be followed. It fit perfectly with their basic beliefs and soon spread elsewhere, including into the home, the conservation movement, and even churches (p. 66-69).

The 1911 publication of Frederick Taylor’s The Principles of Scientific Management was a watershed moment for Progressives. It offered a scientific method for improving workplace efficiency. By measuring and analyzing everything from workplace break times to the weight of shoveled material, industry would be able to maximize efficiency down to the minute and the pound. Taylorism has since become an epithet, used to describe the dehumanizing effects of the time clock, the oppressive nature of constant managerial supervision, and the turn away from skilled labor in the workforce. However, for Progressives it promised a new approach to the workplace that could make life better for everyone. Those experts who would take charge of industry would be able to maximize the public good while minimizing the power of capitalists and financiers. Men such as the Progressive political philosopher Herbert Croly believed that Taylorism would “[put] the collective power of the group at the hands of its ablest members” (p. 62). For Progressives, scientific management was a noble goal and a model to be followed. It fit perfectly with their basic beliefs and soon spread elsewhere, including into the home, the conservation movement, and even churches (p. 66-69).

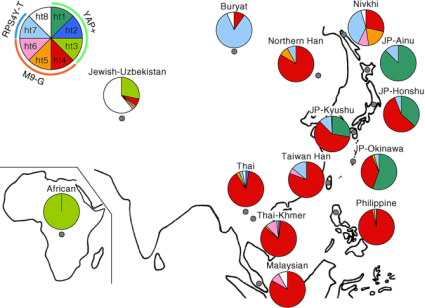

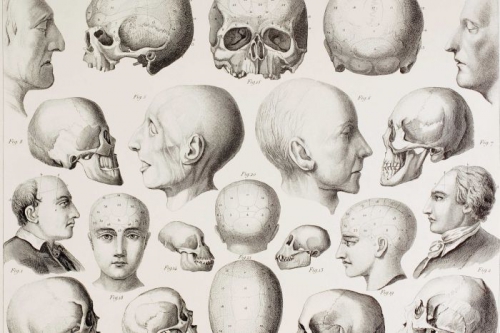

The Progressive era was the era of social science. Scholars, commissioners, politicians, and journalists set out to understand the reality of American social life through scientific methods. Few reading this will be surprised with the conclusions of virtually all of these efforts. What this research — into race, into immigration, into domestic behavior, into social conditions — demonstrated was that there was a clear correlation between race and intelligence and the ability to function in American society. Intelligence tests and vast amounts of data collected from the military and immigration centers were collected and analyzed. For Progressives, race science was obviously and demonstrably real and had to be treated with the same scientific objectivity as the economy or any other facet of human existence. America was then, as it is now, being populated rapidly with provably inferior and/or inassimilable human beings. Progressives began to warn of the dangers of Jewish and other non-white immigration to the United States, as well as the problems stemming from rapidly breeding inferior American citizens.[1]

Chapter five, entitled “Valuing Labor: What Should Labor Get?,” describes how Progressives dealt with the question of labor. They sought to determine what labor was getting, how wages were determined, and what labor should get (p. 78). Dr. Leonard writes:

For nearly all of recorded history, the notion of laborers selling their labor services for wages was nonsensical. Labor was the compelled agricultural toil of social inferiors in the service and under the command of their betters. In the United States, this remained true well into the nineteenth century. The value of labor depended on what the worker was — free or slave, man or woman, native or immigrant, propertied or hireling — not what the worker produced or wished to consume (p. 78).

The thinking behind these categories is treated with contempt by the author, of course. The idea that the labor of a black man could be worth less than that of a white man based on something external to mere prejudice against “skin color” or that the labor of an immigrant could be worth less than the labor of a citizen to those who might feel a deeper affinity for their own countrymen was, to him, symptomatic of a “hierarchy that plagued economic life” (p. 79). He relates the claims of race science with contempt but offers no justification for his disdain. But, by simply ignoring the reality of race and sex differences, the author is able to trace the concept of inferior labor back to the Greeks — as if attitudes towards labor even between similar peoples are not themselves historically contingent.

The author sees two fundamental and separate approaches to political economy throughout history: “market exchange and administrative command” (p. 79). He notes correctly that in the centuries between Socrates and Adam Smith, the market was seen as a place of chaos, disorder, Jews (he uses the semi-cryptic “Shylocks” rather than Jews), and unscrupulous persons of various sorts. The Greek prioritization of the political over the economic is, for Dr. Leonard, the source of the various manifestations of human hierarchies in Western societies and economies.[2] [3] Greek men somehow just decided for no valid reason whatsoever that women should supervise the household, market services be left to foreigners, and labor relegated to non-Greeks. These were simply ideas that had “extraordinary staying power in Europe” (p. 80) and thus led to aristocracy and other unnatural hierarchies until Adam Smith blessed Europe with his belief in individualism and natural liberty. Again, the author deliberately chooses to ignore the very real biological bases for such facts of human social life. Command economies are, to the author, somehow “bad” because he sees them as having been based in ignorance and vaguely conspiratorial hierarchical social arrangements.

Enlightenment notions of individualism and liberty were, of course, central to the rhetoric of the American project. However, America did not practice what it preached (nor did it really preach “what it preached” but that is far beyond the scope of this piece): slavery existed in the South and was defended by Southerners as far more humane than the wage-slavery of the North; Northern abolitionists saw this as an absurd comparison and argued that at least free laborers could get up and leave if they were unhappy. But both saw the laborer in one form or another as being an inferior creature. This attitude was to carry through to the Progressive era. As the author puts it, “reformers still saw a bit of the slave in the wage earner, no matter how ubiquitous the employee now was” (p. 84). He goes on to note that when millions of women and immigrants joined the workforce, this reinforced the notion of the laborer as inferior.[3] [4]

If the laborer is inferior, what should they be paid? Progressives believed in the power of the government to change social conditions. As such, they believed that policies could be enacted that would enable laborers to live comfortably, with enough money to be upstanding citizens and raise healthy families. Differing theories existed for how fair wages should be determined, but Progressives tended to reject the idea that wages were anything less than a “worker-citizen’s rightful claim upon his share of the common wealth produced when the laborer cooperated with the capitalist to jointly create it” (p. 86). As is always the case among economists, vigorous debate ensued. The goal was for workers to receive a living wage but how this was to be accomplished was a matter of some controversy. The author discusses some of these theoretical disagreements but concludes that the one thing that united all Progressives in this matter was the belief that “work will always go to the lowest bidder . . . there was a race to the bottom, and the cheapest labor won” (p. 88). However, he pathologizes this as an “anxiety” rather than a real problem experienced by rational people so that Progressive concerns about the intersection of economy and race be seen by the reader as a kind of irrational social “disease,” a collective neurosis with deep roots in the American (read white) psyche.

In chapter six, “Darwinism in Economic Reform,” Dr. Leonard relates how Darwinism was used by Progressives to acquire the “imprimatur of science” (p. 105). Darwinism proved to be a very flexible conceptual tool. It allowed for incorporation into various fields of thought and, within those, still more differing points of view: it was used to advocate for capitalism and for socialism; war and peace; individualism and collectivism; natalism and birth control; religion and atheism (p. 90). Darwinism and related ideas (such as Lamarckism) provided Progressives with a scientific basis upon which to argue for both economic improvement and biological improvement. There was no consensus on which aspects of Darwinism to incorporate into their logic but something the vast majority had in common was the belief in the importance of heredity and that artificial selection, as opposed to natural selection, was the most efficient means of securing a healthy society comprised of evolutionarily fit individuals.

In chapter six, “Darwinism in Economic Reform,” Dr. Leonard relates how Darwinism was used by Progressives to acquire the “imprimatur of science” (p. 105). Darwinism proved to be a very flexible conceptual tool. It allowed for incorporation into various fields of thought and, within those, still more differing points of view: it was used to advocate for capitalism and for socialism; war and peace; individualism and collectivism; natalism and birth control; religion and atheism (p. 90). Darwinism and related ideas (such as Lamarckism) provided Progressives with a scientific basis upon which to argue for both economic improvement and biological improvement. There was no consensus on which aspects of Darwinism to incorporate into their logic but something the vast majority had in common was the belief in the importance of heredity and that artificial selection, as opposed to natural selection, was the most efficient means of securing a healthy society comprised of evolutionarily fit individuals.

Social Darwinism was a concept championed by believers in the free market. As the author notes, it was always a used as a pejorative and Progressives had to distance themselves from it (p. 99). They did so by challenging laissez-faire using Darwinist principles, an idea that came to be known as Reform Darwinism. The Reform Darwinists, led by the sociologist and botanist Lester Frank Ward, challenged laissez-faire by asserting that capitalists thrived in the Gilded Age because “they had traits well adapted to the Gilded Age” but that these traits were not necessarily “socially desirable” (p. 100). They also asserted that society was an organism that “had a necessary unity” but “not an inclusive one” (p. 102). An organism must always protect itself from threats and an organism must also prioritize the whole over the part. This organic model of society influenced every Progressive concern. If, for example, a corporation was a legal person entitled to the same protections as an individual citizen, then surely “the state was an even larger organism, one that encompassed and thus subsumed corporate and natural persons alike” (p. 100).

Progressives also attacked natural selection as “wasteful, slow, unprogressive, and inhumane” (p. 100). Agreeing that robber barons and rich fat cats were an example of the degenerative tendencies of capitalism, society had a duty to protect itself from such people (p. 100). Natural selection did not always lead to progress. It was environmentally contingent. Richard Ely argued that “Nature, being inefficient, gives us man, whereas society ‘gives us the ideal man'” (p. 104). The free market rewarded those who could make the system work to their advantage by any means necessary, not those who possessed traits that were desirable for a healthy, moral society. Regulation could help fix this problem. Woodrow Wilson wrote that “regulation protected the ethical businessman from having to choose between denying his conscience and retiring from business” (p. 105). Combined with German economics, German historical theory, an activist sociology, and a commitment to the benefits of efficiency, the influence of Darwinism made the development of workable eugenics policies almost a certainty.

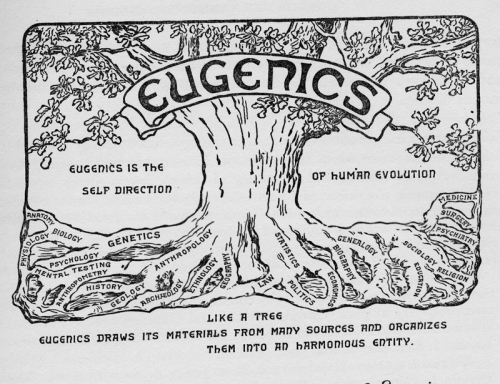

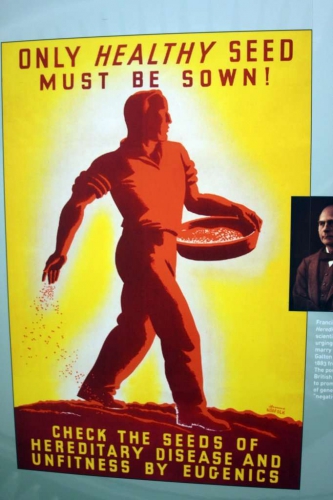

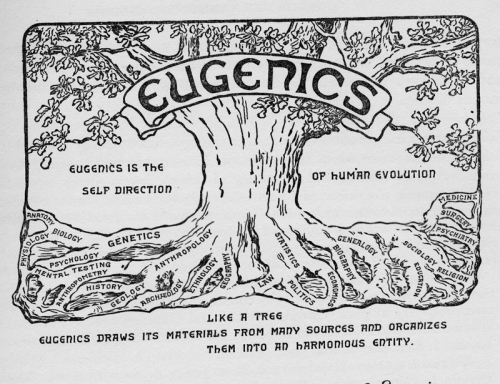

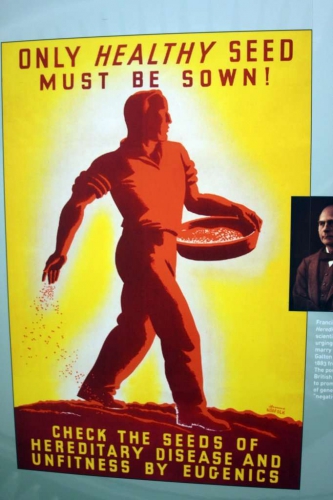

In the seventh chapter of the book, “Eugenics and Race in Economic Reform,” Dr. Leonard provides a brief overview of the history of eugenics. He also describes how it entered American intellectual discourse and how it was applied to race science. With roots as far back as Plato and popularized by Francis Galton in the late 19th century, eugenics was the obvious solution to many of the social problems that the Progressives were tackling. The author quotes Galton for a broad explanation: “what nature does blindly, slowly, and ruthlessly, man may do providently, quickly and kindly” (p. 109). The ideas of eugenicists gained mainstream traction rapidly. By the early 20th century, states were passing sterilization laws. By the end of World War I, concerns about the terrible death toll of white men had prompted many American intellectuals to worry deeply about the crisis caused by the loss of so much “superior heredity” (p. 110). American universities began teaching eugenics courses, textbooks on eugenics were written, journals were published, and societies devoted to encouraging the spread of eugenics programs and race science were created.

Francis Galton had gone so far as to declare a “Jehad [sic]” on the “customs and prejudices that impair the physical and moral qualities of our race” (p. 112). Influential Progressives like Irving Fisher and John Harvey Kellogg sought to make this a reality by creating a sort of religion out of eugenics (p. 112). Concern for the white race played an explicit part in Progressive thought. There was nothing coded about it. Like the social gospelers of early Progressivism, the eugenics movement evangelized very effectively. The concept of racial health was soon to be found virtually everywhere one turned, from women’s magazines, movies, and comic strips to “fitter family” and “better baby” contests at agricultural fairs across America (p. 113). Lothrop Stoddard published his classic The Rising Tide of Color Against White World-Supremacy in 1920, and the famous Supreme Court decision in the case of Buck v. Bell in 1927 affirmed that the state had a right to sterilize individuals deemed a genetic threat to society. It is important to note that not all eugenicists were Progressives but the vast majority of Progressives were eugenicists. For them, things such as environmental conservation went hand in hand with racial “conservation.”

For Progressive eugenicists, the administrative state was the most effective defense against racial degeneration (the effects of adverse conditions on a race of people) and race suicide (the effects of a superior race being outbred by inferior races) (p. 117). Poor and uneducated whites were seen to be redeemable given the proper environmental conditions and thus genetically able to assimilate into American society. Non-whites were incapable of assimilation because of their lower intelligence and racially-specific habits and attitudes. Of particular concern was the American black population. White Progressives saw them, at best, as docile children who should be treated as such for the good of all, and, at worst, as a weight that would sap American energy and character (p. 122). Even among the handful of black Progressives, such as W.E. B. DuBois and Kelly Miller, race was seen as a problem for America. Though they rejected the notion of the genetic inferiority of blacks, they recognized that the rapidly breeding lowest IQ blacks threatened to overwhelm the elite few — the “Talented Tenth,” as DuBois famously described them (p. 122).

But non-whites were not the only concern of the Progressive eugenicists. As indicated above, racial degeneration was of great concern. Literature on degenerate families became wildly popular at this time, bringing to the American lexicon such names as the Jukes and the Kallikaks. These families (given aliases by the authors of these studies) had their histories published as warnings about the dangers of what some would now refer to as “white trash.” The contradictions here are apparent: Progressives sought to improve the conditions of the white poor while at the same time wrestling with the question of whether poor whites were genetically unfit and simply irredeemable by external measures. The latter question, however, was also asked of the rich, who some Progressives saw as even better evidence of racial degeneracy. As with every other issue, there was a certain amount of disagreement among Progressives about specific questions and how to best administer solutions, but the concerns themselves were universal.

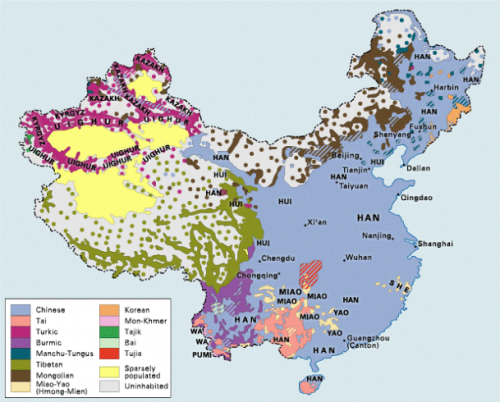

Perhaps the greatest concern was with the effects of immigration on the American gene pool. The author subscribes to the notion of an imagined “whiteness” and, as is customary, uses the Anglo-Saxonist tendencies of Progressives to call into question the validity of race science. This is to be expected and can be ignored. But it was indeed a concern of the era, especially as immigrants poured onto American shores. Some Progressives argued that democracy had its origins in the Anglo-Saxon race and that immigration from other areas of Europe was detrimental to survival of the American way of life. Walter Rauschenbach, a “radical social gospeler” (p. 124) argued that capitalism “drew its ever-increasing strength from the survival of the unfit immigrant” (p. 125). Rauschenbach was a committed Anglo-Saxonist and such views had long held sway in Progressive circles, from social gospelers to anti-Catholics to Prohibitionists. But it does not follow that concerns about immigration were irrational because one particular group of whites at the time did not like the customs of another group of whites. Nor do these antiquated distinctions invalidate the entirety of race science, however many times they are used in attempts to do so by this author and so many others.

Chapter eight is entitled “Excluding the Unemployable.” In it the author delves into how Progressives related racial inferiority and other traits deemed as markers of inferiority to labor and wages. He writes: “The Progressive Era catalog of inferiority was so extensive that virtually any cause could locate some threat to American racial integrity” (p. 129). Obviously, non-whites were seen as a threat, but so were white alcoholics, the poor, epileptics, and others. He argues that in antebellum America, laborers knew their place and stayed there. From slaves to women, strict social and sometimes legal controls assured the maintenance of this hierarchy. Postbellum industrialization and the emancipation of slaves threatened this order: “Inferiors were now visible and perceived to be economic competitors” and were either “portrayed as the exploited dupes of the capitalist” or “as the capitalist’s accomplices” (p. 130). Those who were literally incapable of work and those who were willing to work for lower wages than “superior” Anglo-Saxon stock were given the label “unemployable.”

These “unemployables” were seen as being parasitic. They undercut wages and threatened American racial integrity. The capitalist drive towards cheap labor was certainly seen as partly to blame for this problem, but Progressive discourse began to focus more on biology than economics. Blame was increasingly shifted towards the actual laborers themselves rather than the system that encouraged them to accept lower wages. In what was known as the “living-standard theory of wages,” the unemployables were seen as being able to live on less than the average American worker due to their willingness (either racially-determined or resulting from inferior minds) to accept poor living conditions. The white American worker, it was believed, would reduce his number of children rather than sacrifice his standard of living, thereby increasing the risk of Americans being outbred by inferior stock. This line of argument gained popular currency with the sometimes violent union activism against Chinese workers. Edward Ross wrote that “should wors[e] come to the worst, it would be better for us if we were turn our guns upon every vessel bring [Asians] to our shores rather than permit them to land” (p. 135). The notion of immigrants and others being regarded as scab labor was widely accepted across the political spectrum but was central to Progressive concerns because they were able to see it as symptomatic of multiple grave problems with American society. In order to correct these problems, better methods were needed to identify and exclude the inferiors who were threatening American jobs and lowering the American quality of life.

These “unemployables” were seen as being parasitic. They undercut wages and threatened American racial integrity. The capitalist drive towards cheap labor was certainly seen as partly to blame for this problem, but Progressive discourse began to focus more on biology than economics. Blame was increasingly shifted towards the actual laborers themselves rather than the system that encouraged them to accept lower wages. In what was known as the “living-standard theory of wages,” the unemployables were seen as being able to live on less than the average American worker due to their willingness (either racially-determined or resulting from inferior minds) to accept poor living conditions. The white American worker, it was believed, would reduce his number of children rather than sacrifice his standard of living, thereby increasing the risk of Americans being outbred by inferior stock. This line of argument gained popular currency with the sometimes violent union activism against Chinese workers. Edward Ross wrote that “should wors[e] come to the worst, it would be better for us if we were turn our guns upon every vessel bring [Asians] to our shores rather than permit them to land” (p. 135). The notion of immigrants and others being regarded as scab labor was widely accepted across the political spectrum but was central to Progressive concerns because they were able to see it as symptomatic of multiple grave problems with American society. In order to correct these problems, better methods were needed to identify and exclude the inferiors who were threatening American jobs and lowering the American quality of life.

In chapter nine, “Excluding Immigrants and the Unproductive,” Dr. Leonard examines the methods used for exclusion. The most obvious method was the use of immigration restrictions. Numerous laws were enacted either limiting or barring entirely immigration from certain parts of the world. Restrictions were also imposed by those otherwise deemed a threat to the country, i.e. anarchists, polygamists, and epileptics (p. 142). In 1905, a law was passed that prohibited contract labor altogether (companies paying immigrants to come to America in exchange for labor). A literacy test was also proposed for anyone trying to enter the country, however the effort actually failed when Woodrow Wilson inexplicably vetoed the bill in 1917. Edward Ross blamed Jews for this loss. He wrote that they were financing the anti-restrictionist campaign and pretending that it was for the benefit of all immigrants but was actually “waged by and for one race” (p. 158). But does the author investigate this claim? Of course not. It is easier to label Ross an anti-Semite and move on. To do otherwise might turn up some uncomfortable facts.

Other restrictionist actions met with success: in 1907, the Expatriation Act required American women who married foreigners to surrender their citizenship; massive federal investigations were undertaken to study the problems of immigration; and various private organizations sprung up devoted to anti-immigration advocacy. (p. 143). For Progressives, the issue of race had become one of their deepest concerns. It was, generally, either considered the main determinant of historical change, for better or for worse, or at least an extremely important one. It comes as no surprise that the founding of the United States would be interpreted through a Darwinist lens by Progressives. The author spends some time critiquing their use of Darwinist concepts to defend the original colonists as pioneers and conquerors (that is, “fit”) and later immigrants as simply following a path already tread in opportunistic fashion (“unfit”). Never mind that this is quite obviously at least partially true. He even fails to see the distinction between a colonist and an immigrant, wholeheartedly buying into the ridiculous “nation of immigrants” theory of American demographics that is so popular today.

Progressive eugenicists saw the immigration problem as an opportunity to assert their particular interests. Interest in race science grew exponentially. Various classificatory systems were proposed, studied, and refined, each of which generally had the expected hierarchies: whites at the top, blacks on the bottom. Within each category were, of course, numerous other sub-categories. But almost all races (both in the contemporary sense and in older sense meaning “ethnicity”) was charted and described in great detail. It was crucial from the standpoint of the Progressive eugenicists to use this information to prevent the race conflict that they believed would naturally arise from the intermingling of dissimilar peoples from across the globe. Even the few Progressive intellectuals who were genuinely egalitarian in outlook believed that race-based immigration policies were crucial. John Dewey, for example, supported them because he believed average Americans were too primitive to adopt his supposedly enlightened view that race was a fiction, thus making race conflict inevitable anyway (p. 153). Unsurprisingly, those who opposed immigration restrictions tended to be Jews such as Franz Boas, philosemites such as Emily Balch, and/or laissez-faire capitalists. The motives of the restrictionists are called into question by the author — but not those of the anti-restrictionists, of course. They were simply uniquely informed and tolerant for their time.

The above also fueled the debate over the minimum wage. It was commonly accepted that a legal minimum wage would put some people out of work. Progressives tended to see this as a good thing insofar as it removed inferior laborers from the job market. Dr. Leonard writes: “It deterred immigrants and other inferiors from entering the labor force, and it idled inferior workers already employed. The minimum wage detected the inferior employee, whether immigrant, female, or disabled, so that he or she could be scientifically dealt with” (p. 161). Ways in which these inferiors could be dealt with “scientifically” included simple things such the return of formerly-employed women to the home and far more complex solutions such as labor colonies for the unfit and forced sterilization. As was the case with all internecine Progressive debates, however, the thinking was always keenly focused on future generations. One particular intellectual might disagree with another about a certain policy proposal or belief, but the goal was the same: a harmonious society and healthy race. And since neither can exist without women, it was natural for Progressives to consider the role of women in society.

In the tenth and final chapter of the book, entitled “Excluding Women,” Dr. Leonard examines the views of women’s employment and civil rights within the Progressive movement. Women were always an important part of efforts at labor reform and the drive to improve various aspects of social life. But most Progressives had very strong views on the proper role of women in society. Richard Ely argued that women should be barred from the workplace (p. 170). Many, however, did not go to quite to this extreme. Efforts were made to simply limit the number of hours women were legally allowed to work, for example. The idea behind this was, of course, that women were physically weaker and needed protection from exploitative employers. But there were other issues of importance to Progressives as well, including the desire to combat prostitution. This concern was sometimes used to defend the minimum wage. If working women could make more money per hour they would be less likely to resort to prostitution to make ends meet. The obvious problem here is that the minimum wage was supposed to make certain people unemployed, and this group included women. It was assumed, however, that unemployed women would be cared for by the men in their lives, thereby providing the benefits of higher wages to men, a more appropriate environment for women, and helping to guarantee the health of the race. Whatever limitations this placed on a woman’s individual rights were explicitly justified by concern for the race.

For some Progressive feminists, male social domination had had a dysgenic effect by punishing the race’s strongest women by confining them to the household (p. 179). Most Progressives, however, believed that motherhood was the duty of women and had to be encouraged and thought such ideas absurd. Theodore Roosevelt, for example, had special contempt for those women from privileged backgrounds who did not have enough children despite being able to afford it. Referring to them as “race criminals,” he believed that such behavior was the height of selfishness (p. 180).

The debate over birth control was related to this attitude. Birth control, then as now, was mostly used by the most privileged in society and less so by the lowest classes. It thus had an obvious dysgenic effect. The author sees the synchronic concerns of Progressives with women’s health, sexual virtue, economic competition with men, and health of the race as contradictory. He writes:

If she were paid very little, she was admonished for endangering her health, risking her virtue, and threatening hereditary vigor. If she commanded a slightly higher but still modest wage, she was condemned for undercutting men’s family wages and for neglected [sic] her maternal duties. If she were well paid, she was admonished for selfishly acquiring an education, pursuing a career, and thus shirking her reproductive responsibilities to society and the race (p. 182).

Though there is a superficial tension between these things, he fails to see that there is no necessary contradiction here. It is entirely possible for women to be economically exploited laborers whose employment lowered men’s wages and for their ideal place to be in the home, nurturing the future of the race. Progressives generally saw the employment of women as a precursor to starting a family or as a result of misfortune anyway (p. 178). Sex-specific protections in the workplace, as well as a minimum wage that would displace many of them, would be a perfectly sensible goal for any state that had the future of the race as a primary focus. Dr. Leonard’s concern with finding hypocrisy in every statement relating to race and sex blinds him to reasonable conclusions. The Progressives, however, were not handicapped by ideological taboos and ultimately rejected the small, internal strain of equal-rights feminism within their ranks in favor of protecting the race. Progressives fought hard against the Equal Right Amendment of 1923, but by the mid-1920s, the Progressive Era was winding down and within a few years the zeitgeist would change considerably.

We see in the Progressive movement the last explicit, mainstream advocacy for the white race on American soil. The author clearly realizes this and chooses to ignore every single claim made by Progressives that does not fit with contemporary notions of social constructivism. He quotes Progressives in order to mock them, not to investigate whether what they said had a basis in fact. One might object by saying that it is beyond the scope of the book to investigate race science itself in order to discuss its role in the Progressive era. But the book starts out with the lie that race science has been discredited and everything that follows is therefore either directly based on a lie or has a lie as its overarching context. The point of the book, however, is not to enlighten the reader about anything of substance. His goal is merely to frown upon “racists” and “sexists” with the reader, to roll his eyes at ignorant Progressives along with his academic colleagues, and pray that his book is assigned in universities across the country in order to further indoctrinate students into the secular religion of egalitarianism.

This is not to say that there are not important issues discussed in the book. Clearly, there are. Nor is any of the above meant to suggest that Progressives were correct about everything. Clearly, they were not. But one cannot help but wonder how different America would look today if the Progressives had been able to further investigate and discuss these important issues as a part of the mainstream. What would this country look like now if such ideas had not been turned into “thought crimes?” In so many ways what we see in progressives today is a complete about-face from the intellectual heritage they claim. And in so many ways what we can see in the real Progressive movement is profoundly, devastatingly prescient and of utmost relevance to the contemporary American sociopolitical landscape. These issues are just too important to be left to a hack.

Notes

1. As many readers will be aware, there was a distinct bias towards Nordics among American whites at this time. Many Southern and Eastern European whites were deemed inferior–a hammer used frequently to hit racialists over the head in arguments intended to “deconstruct” whiteness. It is also, unfortunately, still found in White Nationalist circles. Nordicism is dealt with very well by Greg Johnson here (http://www.counter-currents.com/2016/03/nordics-aryans-an... [5]).

2. One wonders how he might explain similar hierarchies in non-European civilizations.

3. How labor would have fared in the 20th century without the presence of millions of women and immigrants to bolster notions of their inferiority is a question that should be asked of every contemporary “progressive.” One might also ask why, if racial diversity is such a tremendous and obvious social good, how it is that highly-educated Progressives completely failed to realize this — especially considering that theirs was a mission to increase the standard of living in America.

Related

Je n’hésite plus à mettre entre parenthèses tout ce qu’on sait au croit savoir sur l’antisémitisme de Céline, suivant en cela l’exemple de l’homme qui aurait eu le plus de raisons de jeter l’anathème sur lui, George Steiner, un juif bien formé et bien informé qui, au lieu de nier le génie là où il le voyait associé aux passions les plus funestes, s’inclinait devant le mystérieux scandale de leur coexistence dans un même être, sans jamais exclure que, dans les mêmes circonstances , il aurait pu lui-même dériver vers les mêmes excès. Je reviens sur cette question dans un article distinct sur Steiner.

Je n’hésite plus à mettre entre parenthèses tout ce qu’on sait au croit savoir sur l’antisémitisme de Céline, suivant en cela l’exemple de l’homme qui aurait eu le plus de raisons de jeter l’anathème sur lui, George Steiner, un juif bien formé et bien informé qui, au lieu de nier le génie là où il le voyait associé aux passions les plus funestes, s’inclinait devant le mystérieux scandale de leur coexistence dans un même être, sans jamais exclure que, dans les mêmes circonstances , il aurait pu lui-même dériver vers les mêmes excès. Je reviens sur cette question dans un article distinct sur Steiner. Dans l’hôpital de Vienne où Semmelweis travaillait en tant qu’obstétricien, il y avait deux services de maternité, celui du professeur Bartch et celui du professeur Klin, dont il était l’adjoint. Après avoir éliminé une à une toutes les hypothèses, aussi farfelues les unes que les autres, rassemblées dans la littérature médicale de l’époque, il n’avait plus comme point de départ de son enquête qu’un seul fait : les femmes mouraient plus dans le service de Klin que dans celui de Bartch. Une différence entre les deux sautait aux yeux : dans le pavillon de Bartch le service était rendu par des sages-femmes, dans celui de Klin par des internes. Il a suffi à Semmelweis de signaler ce fait pour se mettre à dos et son patron et bon nombre de ses collègues. Il a en outre exigé avec une insistance incorrecte que les internes se lavent les mains entrant dans le pavillon de Klin; ce dernier, pour qui une telle précaution paraissait dénuée de tout fondement scientifique, le congédia. Les protecteurs de Semmelweis, car il en avait quelques-uns à Vienne, organisèrent pour lui un repos de deux mois à Venise, où il se rendit avec son ami Markusovsky. La merveille ici c’est la façon dont Céline, dans son roman biographique, raconte le séjour de Semmelweis et y voit le prélude à ses découvertes futures.

Dans l’hôpital de Vienne où Semmelweis travaillait en tant qu’obstétricien, il y avait deux services de maternité, celui du professeur Bartch et celui du professeur Klin, dont il était l’adjoint. Après avoir éliminé une à une toutes les hypothèses, aussi farfelues les unes que les autres, rassemblées dans la littérature médicale de l’époque, il n’avait plus comme point de départ de son enquête qu’un seul fait : les femmes mouraient plus dans le service de Klin que dans celui de Bartch. Une différence entre les deux sautait aux yeux : dans le pavillon de Bartch le service était rendu par des sages-femmes, dans celui de Klin par des internes. Il a suffi à Semmelweis de signaler ce fait pour se mettre à dos et son patron et bon nombre de ses collègues. Il a en outre exigé avec une insistance incorrecte que les internes se lavent les mains entrant dans le pavillon de Klin; ce dernier, pour qui une telle précaution paraissait dénuée de tout fondement scientifique, le congédia. Les protecteurs de Semmelweis, car il en avait quelques-uns à Vienne, organisèrent pour lui un repos de deux mois à Venise, où il se rendit avec son ami Markusovsky. La merveille ici c’est la façon dont Céline, dans son roman biographique, raconte le séjour de Semmelweis et y voit le prélude à ses découvertes futures.

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.

La théorie qui semblait pouvoir atteindre cet objectif s’appelle la Théorie des cordes, devenue ensuite la Théorie des Supercordes. Cette théorie est un exemple éclatant de ce que le physicien quantique Lee Smolin n’hésite pas à qualifier de situation tragique de la physique théorique contemporaine: «Pour parler franchement, nous avons échoué: nous avons hérité d’une science, la physique, qui avait continué à progresser à une vitesse si grande qu’elle était souvent prise comme modèle pour d’autres sciences. Notre compréhension des lois de la nature a continué à croître rapidement pendant plus de deux siècles, mais aujourd’hui, malgré tous nos efforts, nous ne savons plus avec certitude plus de choses sur ces lois qu’au début des années 1970» (L’univers sans cordes. La fortune d’une théorie et les troubles de la science, éd. it.: Einaudi, Turin 2007, p. X). Étant donné le poids considérable que les sciences, et en particulier la physique, ont dans la société contemporaine, il s’agit d’une tragédie qui n’est pas seulement épistémologique, mais aussi une crise sociale montrant certaines racines profondes des situations que nous avons vécues ces dernières années.  La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149).

La théorie postule également l’existence de tachyons, des particules capables de voyager à des vitesses supérieures à celle de la lumière. Mais «si cela se produit dans une théorie quantique des champs, c’est une indication très précise que cette dernière est en réalité incohérente. Un aspect problématique des tachyons est qu’ils peuvent transmettre des informations en arrière dans le temps, violant ainsi le principe de causalité» (Peter Woit, Pas même faux. L’échec de la théorie des cordes et la course à l’unification des lois de la physique, éd. it.: Codice Edizioni, Turin 2007, p. 149). Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent.

Cet élément si psychologique et existentiel contribue à expliquer comment une telle non-théorie (ou «théorie du rien», comme l’a qualifiée le cosmologiste Lawrence Krauss) non seulement continue d’exister, mais concentre aussi le travail de la majorité des physiciens théoriciens et, surtout, parvient à obtenir des sommes vraiment impressionnantes de la part des organismes qui financent la recherche aux États-Unis. Les raisons sont nombreuses, même si elles se ressemblent. Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Finalement, cette théorie ne possède même pas la beauté mathématique qui, à ses débuts, avait suscité tant d’enthousiasme, étant devenue une théorie dépourvue d’élégance formelle et qui, pour se sauver, recourt de plus en plus à la version contemporaine de l’asile de l’ignorance, le principe anthropique, basé sur la tautologie selon laquelle si nous existons, c’est que l’univers comporte les conditions de notre existence. Ce n’est pas un hasard si la théorie des cordes est devenue un domaine défendu et soutenu par diverses formes de contamination entre la physique et la New Age, dont l’exemple le plus célèbre est Le Tao de la physique de Fritjof Capra.

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

Smolin a écrit que la théorie des cordes dessine une véritable «physique postmoderne», formule non ironique, utilisée par ses propres partisans et non par ses opposants: «La sensation était qu’il ne pouvait exister qu’une seule théorie cohérente pour unifier toute la physique, et comme la théorie des cordes semblait le faire, elle devait être correcte. Il ne fallait plus dépendre des expériences pour vérifier les théories! C’était du Galileo. Désormais, seule la mathématique permettait d’explorer les lois de la nature. Nous étions entrés dans l’ère de la physique postmoderne» (Smolin, p. 117).

del.icio.us

del.icio.us

Digg

Digg

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

Avec cette contribution, nous poursuivons notre réflexion sur le parcours "Hyperindustrie" de la colonne Transuenze. Le texte suivant est la transcription, révisée par la rédaction, d'un discours prononcé par Franco Piperno (foto, ci-contre-, physicien académique et intellectuel militant qui ne devrait pas nécessiter d'autre introduction dans ces pages, lors de l'université d'été organisée par Machina à la fin de l'été dernier. Piperno, d'une manière inévitablement synthétique, approfondit certains des nœuds profonds du capitalisme tardif, qui tire sa puissance de l'assujettissement et de la fonctionnalisation de la science à la technologie, dans l'appauvrissement des capacités cognitives sociales et de la connaissance scientifique elle-même. Cependant, le triomphe de la technoscience coïncide avec une crise profonde et manifeste de ses hypothèses épistémologiques mêmes. Les implications de cette réflexion sur la nature du capitalisme hyper-industriel, ou capitalisme technologique comme l'appelle l'auteur en l'opposant au capitalisme "cognitif", et sur nombre des thèmes que nous souhaitons explorer (l'innovation, la qualité du travail, l'ancienne et la nouvelle division sociale du travail, la nécessité d'une critique radicale et non obscurantiste du progrès technologique), nous semblent évidentes, voire incontournables.

Elon Musk

Elon Musk

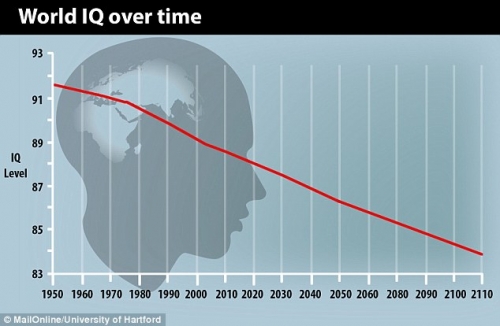

Comme preuve que le QI des Noirs américains à un

Comme preuve que le QI des Noirs américains à un  La raison proposée par Woodley de Menie et son équipe est simple. En fait, elle a été conjecturée dès le XIXe siècle, car des gens comme Charles Darwin avaient prédit qu’il y aurait des «

La raison proposée par Woodley de Menie et son équipe est simple. En fait, elle a été conjecturée dès le XIXe siècle, car des gens comme Charles Darwin avaient prédit qu’il y aurait des «  Essentiellement, Demeneix

Essentiellement, Demeneix

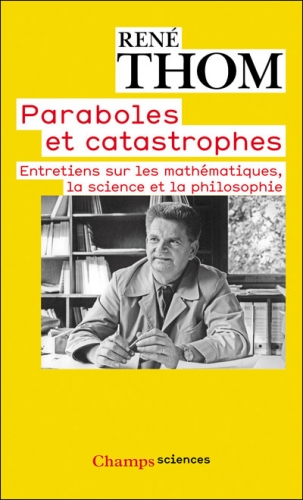

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

It was most likely in the context of this scientific tradition and its enemies that Johann Wolfgang von Goethe, generally recognized as Germany’s greatest poet (or one of them, at any rate), later authored attacks on Newton’s ideas, such as Theory of Colors. Goethe, an early pioneer in biology and the life sciences, loathed the notion that there is anything universally axiomatic about the mathematical sciences. Goethe had one major predecessor in this, the Anglo-Irish philosopher and Anglican bishop George Berkeley. Like Berkeley, Goethe argued that Newtonian abstractions contradict empirical understandings. Both Berkeley and Goethe, though for different reasons, took issue with the common (or at least, commonly Anglo-Saxon) wisdom that “mathematics is a universal language.”

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.

Cuvier, however, does not belong to the German transcendentalist tradition, so Spengler mentions him only peripherally. On the other hand, in the third chapter of the second volume of The Decline of the West, Spengler uses a word that Charles Francis Atkinson translates as “admitted” to describe how Cuvier propounded the theory of catastrophism. Clearly, Spengler shows himself to be more sympathetic to Cuvier than to what he calls the “English thought” of Darwin.

Apollinische antieke wiskunde

Apollinische antieke wiskunde

In many ways the Progressive Era embodies the best of white America. It was a period of compassion, community concern, attempts to raise the living standard of average Americans, a desire to achieve class harmony, to end (or at least reduce) capitalist corruption, and to create a workable, harmonious racial nationalism that would ensure the long-term fitness of American society. The concerns of the Progressives were as much for the future as they were for the present, something almost wholly lacking in contemporary American politics. These scholars, politicians, and activists thought deeply about future generations and recognized, almost to a man, the validity of race science and the crucial role race plays in the historical trajectory of any country.

In many ways the Progressive Era embodies the best of white America. It was a period of compassion, community concern, attempts to raise the living standard of average Americans, a desire to achieve class harmony, to end (or at least reduce) capitalist corruption, and to create a workable, harmonious racial nationalism that would ensure the long-term fitness of American society. The concerns of the Progressives were as much for the future as they were for the present, something almost wholly lacking in contemporary American politics. These scholars, politicians, and activists thought deeply about future generations and recognized, almost to a man, the validity of race science and the crucial role race plays in the historical trajectory of any country.

The 1911 publication of Frederick Taylor’s The Principles of Scientific Management was a watershed moment for Progressives. It offered a scientific method for improving workplace efficiency. By measuring and analyzing everything from workplace break times to the weight of shoveled material, industry would be able to maximize efficiency down to the minute and the pound. Taylorism has since become an epithet, used to describe the dehumanizing effects of the time clock, the oppressive nature of constant managerial supervision, and the turn away from skilled labor in the workforce. However, for Progressives it promised a new approach to the workplace that could make life better for everyone. Those experts who would take charge of industry would be able to maximize the public good while minimizing the power of capitalists and financiers. Men such as the Progressive political philosopher Herbert Croly believed that Taylorism would “[put] the collective power of the group at the hands of its ablest members” (p. 62). For Progressives, scientific management was a noble goal and a model to be followed. It fit perfectly with their basic beliefs and soon spread elsewhere, including into the home, the conservation movement, and even churches (p. 66-69).

The 1911 publication of Frederick Taylor’s The Principles of Scientific Management was a watershed moment for Progressives. It offered a scientific method for improving workplace efficiency. By measuring and analyzing everything from workplace break times to the weight of shoveled material, industry would be able to maximize efficiency down to the minute and the pound. Taylorism has since become an epithet, used to describe the dehumanizing effects of the time clock, the oppressive nature of constant managerial supervision, and the turn away from skilled labor in the workforce. However, for Progressives it promised a new approach to the workplace that could make life better for everyone. Those experts who would take charge of industry would be able to maximize the public good while minimizing the power of capitalists and financiers. Men such as the Progressive political philosopher Herbert Croly believed that Taylorism would “[put] the collective power of the group at the hands of its ablest members” (p. 62). For Progressives, scientific management was a noble goal and a model to be followed. It fit perfectly with their basic beliefs and soon spread elsewhere, including into the home, the conservation movement, and even churches (p. 66-69). In chapter six, “Darwinism in Economic Reform,” Dr. Leonard relates how Darwinism was used by Progressives to acquire the “imprimatur of science” (p. 105). Darwinism proved to be a very flexible conceptual tool. It allowed for incorporation into various fields of thought and, within those, still more differing points of view: it was used to advocate for capitalism and for socialism; war and peace; individualism and collectivism; natalism and birth control; religion and atheism (p. 90). Darwinism and related ideas (such as Lamarckism) provided Progressives with a scientific basis upon which to argue for both economic improvement and biological improvement. There was no consensus on which aspects of Darwinism to incorporate into their logic but something the vast majority had in common was the belief in the importance of heredity and that artificial selection, as opposed to natural selection, was the most efficient means of securing a healthy society comprised of evolutionarily fit individuals.

In chapter six, “Darwinism in Economic Reform,” Dr. Leonard relates how Darwinism was used by Progressives to acquire the “imprimatur of science” (p. 105). Darwinism proved to be a very flexible conceptual tool. It allowed for incorporation into various fields of thought and, within those, still more differing points of view: it was used to advocate for capitalism and for socialism; war and peace; individualism and collectivism; natalism and birth control; religion and atheism (p. 90). Darwinism and related ideas (such as Lamarckism) provided Progressives with a scientific basis upon which to argue for both economic improvement and biological improvement. There was no consensus on which aspects of Darwinism to incorporate into their logic but something the vast majority had in common was the belief in the importance of heredity and that artificial selection, as opposed to natural selection, was the most efficient means of securing a healthy society comprised of evolutionarily fit individuals. These “unemployables” were seen as being parasitic. They undercut wages and threatened American racial integrity. The capitalist drive towards cheap labor was certainly seen as partly to blame for this problem, but Progressive discourse began to focus more on biology than economics. Blame was increasingly shifted towards the actual laborers themselves rather than the system that encouraged them to accept lower wages. In what was known as the “living-standard theory of wages,” the unemployables were seen as being able to live on less than the average American worker due to their willingness (either racially-determined or resulting from inferior minds) to accept poor living conditions. The white American worker, it was believed, would reduce his number of children rather than sacrifice his standard of living, thereby increasing the risk of Americans being outbred by inferior stock. This line of argument gained popular currency with the sometimes violent union activism against Chinese workers. Edward Ross wrote that “should wors[e] come to the worst, it would be better for us if we were turn our guns upon every vessel bring [Asians] to our shores rather than permit them to land” (p. 135). The notion of immigrants and others being regarded as scab labor was widely accepted across the political spectrum but was central to Progressive concerns because they were able to see it as symptomatic of multiple grave problems with American society. In order to correct these problems, better methods were needed to identify and exclude the inferiors who were threatening American jobs and lowering the American quality of life.

These “unemployables” were seen as being parasitic. They undercut wages and threatened American racial integrity. The capitalist drive towards cheap labor was certainly seen as partly to blame for this problem, but Progressive discourse began to focus more on biology than economics. Blame was increasingly shifted towards the actual laborers themselves rather than the system that encouraged them to accept lower wages. In what was known as the “living-standard theory of wages,” the unemployables were seen as being able to live on less than the average American worker due to their willingness (either racially-determined or resulting from inferior minds) to accept poor living conditions. The white American worker, it was believed, would reduce his number of children rather than sacrifice his standard of living, thereby increasing the risk of Americans being outbred by inferior stock. This line of argument gained popular currency with the sometimes violent union activism against Chinese workers. Edward Ross wrote that “should wors[e] come to the worst, it would be better for us if we were turn our guns upon every vessel bring [Asians] to our shores rather than permit them to land” (p. 135). The notion of immigrants and others being regarded as scab labor was widely accepted across the political spectrum but was central to Progressive concerns because they were able to see it as symptomatic of multiple grave problems with American society. In order to correct these problems, better methods were needed to identify and exclude the inferiors who were threatening American jobs and lowering the American quality of life.